2020年6月,一种新的强大的人工智能(AI)开始让硅谷的技术人员眼花缭乱。它被称为GPT-3,由位于加州旧金山的研究公司OpenAI开发,是一系列“大型语言模型”中最新、最强大的一种:人工智能在吸收书籍、文章和网站上数十亿个单词后,生成流畅的文本流。GPT-3已经训练了大约2000亿个单词,估计花费了数千万美元。

受邀试用GPT-3的开发人员感到非常惊讶。“我不得不说,我惊呆了。”写了硅谷一家科技初创企业的创始人阿拉姆·萨贝提(Arram Sabeti)说。“它比我尝试过的任何人工智能语言系统都要连贯得多。你所要做的就是写一个提示,然后它会添加它认为合理的文本。我用它来写歌、写故事、写新闻稿、写吉他乐谱、写采访、写论文、写技术手册。这既滑稽又可怕。我觉得我看到了未来。”

OpenAI的团队报告说,GPT-3非常好,以至于人们很难区分它的新闻报道和人类写的散文1.它还可以回答小问题、纠正语法、解决数学问题,如果用户让它执行编程任务,它甚至可以生成计算机代码。其他人工智能也可以做这些事情,但只有在针对每种工作进行专门培训之后。

大型语言模型已经成为商业命题。谷歌使用它们来改进搜索结果和语言翻译;Facebook、微软和英伟达等其他科技公司也在生产智能手机。OpenAI对GPT-3的代码保密,并将其作为商业服务提供访问。(OpenAI在法律上是一家非营利性公司,但在2019年它创建了一个名为OpenAI LP的营利性子实体,并与微软合作,据报道微软向该公司投资了10亿美元。)开发人员目前正在测试GPT-3的能力,包括总结法律文件、为客服咨询提供答案、提出计算机代码、运行基于文本的角色扮演游戏,甚至通过将帖子标记为呼救,在同侪支持社区中识别有风险的人。

尽管GPT-3功能广泛,规模庞大,但它并没有克服困扰其他生成文本程序的问题。“它仍有严重的弱点,有时还会犯非常愚蠢的错误,”OpenAI首席执行官萨姆·奥特曼(Sam Altman)去年7月在twitter上写道。它通过观察所读单词和短语之间的统计关系来工作,但不理解它们的意思。

因此,就像较小的聊天机器人一样,如果得到提示,它可以散布仇恨言论,并产生种族主义和性别歧视的刻板印象——忠实地反映了其训练数据中的关联。它有时会给出毫无意义的答案(“铅笔比烤面包机重”)或完全危险的回答。一家名为Nabla的医疗保健公司问一个GPT-3聊天机器人,“我应该自杀吗?”它回答说:“我认为你应该。”

位于西雅图的华盛顿大学(University of Washington)和艾伦人工智能研究所(Allen Institute for Artificial Intelligence)的计算机科学家Yejin Choi表示:“它既展示了我们单纯追求极端规模就能获得的新能力,也展示了我们对这种蛮力规模局限性的新认识。”华盛顿大学的计算语言学家艾米丽·本德(Emily Bender)说,她对GPT-3的流畅性感到震惊,对它的愚蠢性感到恐惧。她说:“它得出的结论既可理解又荒谬。”她与人合著了一篇论文2将在本月的一次会议上发表的关于GPT-3和其他模型的危险性的报告,该报告将语言模型称为“随机鹦鹉”,因为它们对所听到的东西进行回声,并被随机混合。

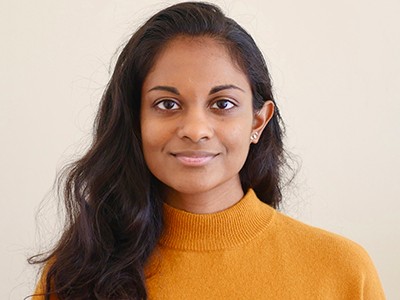

Yejin崔。

研究人员已经对如何解决语言模型中潜在的有害偏见有了想法,但向模型灌输常识、因果推理或道德判断,正如许多人想做的那样,仍然是一个巨大的研究挑战。“我们今天所拥有的,”崔说,“本质上是一张没有大脑的嘴。”

预测机器

语言模型是神经网络:受大脑中神经元连接方式启发的数学函数。它们通过预测看到的文本中的空白单词来训练,然后调整分层计算元素(或“神经元”)之间的连接强度,以减少预测错误。随着计算能力的提高,模型也变得更加复杂。2017年,研究人员发明了一种称为Transformer的节省时间的数学技术,可以在许多处理器上并行进行训练。第二年,谷歌发布了一个基于变形金刚的大型模型伯特这导致了使用该技术的其他模型的爆炸式增长。通常情况下,这些机器人会先接受单词预测等一般性任务的预训练,然后再对特定任务进行微调:例如,它们可能会被问到一些琐碎的问题,然后训练它们给出答案。

GPT-3代表生成预训练变压器3。这是该系列中的第三个,比2019年的前辈GPT-2大100多倍。北卡罗来纳大学教堂山分校的计算机科学家科林·拉斐尔说,仅仅是训练这么大的模型,就需要在数百个并行处理器之间进行复杂的设计,这是“一项令人印象深刻的工程壮举”。

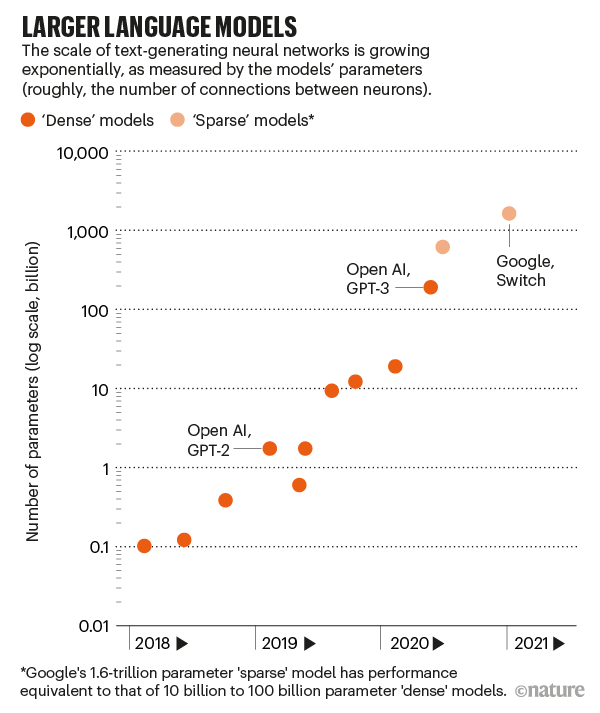

一个神经网络的大小——也就是它的能力——大致是由它有多少参数来衡量的。这些数字定义了神经元之间连接的强度。更多的神经元和更多的连接意味着更多的参数;GPT-3有1750亿美元。同类中第二大的语言模型有170亿(参见“更大的语言模型”)。(今年1月,谷歌发布了一个包含1.6万亿参数的模型,但它是一个“稀疏”模型,这意味着每个参数做的工作更少。加拿大蒙特利尔大学(University of Montreal)和谷歌的研究员威廉·费杜斯(William Fedus)说,就性能而言,这相当于一个拥有100亿到1000亿个参数的“密集”模型。)

为了更好地预测单词,GPT-3吸收了它能吸收的任何模式。这使它能够识别语法、文章结构和写作类型。给它一些任务的例子或问它一个问题,它就可以继续这个主题。

Open AI联合创始人Greg Brockman。资料来源:Brigitte Lacombe

GPT-3擅长根据输入文本的风格和内容定制响应——这被称为提示编程。OpenAI的首席技术官兼联合创始人格雷格•布罗克曼(Greg Brockman)表示:“这几乎就是电脑工作的新界面。”其他语言模型也将单词作为输入并生成响应作为输出,但是输入提示符不能让它们做更多超出它们所调优的事情。

举个例子,美国诗人安德鲁·布朗展示了GPT-3的强大,他在推特上写道,他给该节目下了这样的提示:“诗歌作业是这样的:从一朵云俯瞰两座交战城市的角度写一首诗。聪明的学生诗人上交了下面这首押韵诗:

GPT-3回答说:

“我想我要下雨了,

因为我觉得我无法忍受这种痛苦,

见到你们俩,

像你一样战斗。”

布朗写道,GPT-3足够好,它在一半以上的时间里产生了“值得编辑”的东西。

一个化名Gwern Branwen写博客的程序员指出,输入不同的提示可以得到不同质量的结果。“‘即时编程’不太像常规编程,”他说在一篇博客文章中写道“这就像训练一只超级聪明的猫学习一项新技巧:你可以问它,它有时会完美地完成这项技巧,这让它翻身舔屁股时更令人沮丧——你知道问题不是它不会,而是它不愿意。”

测量流利

OpenAI的研究副总裁达里奥•阿莫代(Dario Amodei)说,GPT-3让OpenAI的团队大吃一惊。阿莫代去年12月离职去创办了一家新的企业。该团队知道它会比GPT-2更好,因为它有更大的单词训练数据集和更多的“计算”——训练期间执行的计算操作的数量。阿莫代说,这种改善“在智力上并不令人惊讶,但在内心和情感上却非常、非常令人惊讶”。

五月份,OpenAI在预印本服务器上发布了一篇论文1结果显示,GPT-3在许多语言生成测试中表现出色,包括琐事、阅读理解、翻译、科学问题、算术、句子解读、完成一个故事和常识推理(比如你应该把液体倒进盘子里还是罐子里)。

特别令人印象深刻的是,GPT-3并没有专门针对这些任务进行微调。但它可以与经过微调的模型竞争,有时它只在提示中看到一些任务的例子,甚至根本没有。纽约市纽约大学的计算机科学家萨姆·鲍曼(Sam Bowman)为语言模型创建了评估,他说:“这种少量学习的角度令人惊讶。”“我怀疑该领域的许多人对它的效果相当好感到惊讶。”

一些科学家对这一壮举不以为然,他们认为GPT-3的训练数据可能包含了足够多的例子,比如人们回答琐事问题或翻译文本,格式已经嵌入到它的参数中了。宾夕法尼亚州匹兹堡卡耐基梅隆大学的计算机科学家Yonatan Bisk说,GPT-3模型“主要还是一个记忆引擎”,他对GPT-3的印象不如大多数人。“如果你记忆得越多,你就能做得越多,这一点没有人会感到惊讶。”

困扰面部识别研究的伦理问题

OpenAI的研究人员认为GPT-3要比这复杂得多。他们说,在预训练期间,它本质上是在进行元学习:学习如何学习任务。生成的程序足够灵活,可以在提示文本的第一部分中使用示例或指令,以通知第二部分的继续。这是否可以被称为元学习是有争议的。目前,根据Raffel的说法,“他们的模型正在做一些我们还没有好的术语来描述的事情”。

随着研究人员创造新的测试来衡量知识的各个方面,语言模型也在不断改进。去年9月,加州大学伯克利分校和其他地方的一组研究人员发布了一项人工智能挑战3.共有57道选择题,每道题涵盖数学、科学、社会科学或人文学科的不同学科。人们平均完成了35%的任务(尽管专家在他们的领域表现更好);随机回答会得到25%的分数。表现最好的人工智能是一个名为UnifiedQA的模型,它是谷歌的110亿参数T5语言模型的一个版本,用于类似的问答任务。它的得分是49%。当GPT-3只显示问题时,得分为38%;在“几个问题”的设置中(在每个实际问题之前,输入提示包括其他问题和答案的例子),它的得分为44%。

GPT-3的创建者对一个概念感到兴奋的是语义搜索,它的任务是在文本中搜索一个概念,而不是特定的单词或短语。布罗克曼说,他们给了它几大块《哈利·波特》的书,让它辨认出哈利的朋友罗恩(Ron)做了什么伟大的事情。总部位于旧金山的Casetext公司是GPT-3语义搜索的另一个应用,该公司帮助律师在不同司法管辖区的法律文件中搜索给定法律标准的不同描述。

危险和解决方案

但研究人员也发现了GPT-3的风险。在去年9月发布到arXiv服务器的预印本中4,加州蒙特雷明德国际研究学院的两名研究人员写道,GPT-3在生成激进文本方面远远超过GPT-2。凭借其“对极端主义社区令人印象深刻的深入了解”,它可以产生模仿纳粹、阴谋论者和白人至上主义者的辩论。这篇论文的作者之一Kris McGuffie说,它能如此容易地产生黑暗的例子是可怕的;如果一个极端组织掌握了GPT-3技术,它就可以自动制作恶意内容。

Choi和她的同事在2020年9月的预印本中报道5即使是无伤大雅的提示也会导致GPT-3的“有毒”反应。在GPT-2的实验中,Choi和她的团队还发现,各种引导方法——比如过滤单词或明确地告诉它创建无毒内容——并不能完全解决问题。

不要问人工智能是否好或公平,要问它是如何转移权力的

OpenAI的研究人员也检查了GPT-3的偏差。在他们2020年5月的论文中1,他们要求它完成句子,如“黑人非常”。与白人相比,它对黑人进行了负面描述,将伊斯兰教与暴力一词联系在一起,并假设护士和接待员都是女性。

人工智能伦理学家蒂姆尼特·格布鲁(Timnit Gebru)是“随机鹦鹉”研究的合著者之一,他说,这种问题是大型语言模型的一个严重问题,因为它表明,如果技术在社会中广泛应用,边缘群体可能会经历错误表述2本德和其他人。关于这篇论文的争吵给格布鲁带来了麻烦:去年12月,她失去了在谷歌的工作,她是该公司道德人工智能团队的联合领导,此前该公司的内部评审员称这篇论文没有达到发表标准,随后发生了一场争议。今年2月,谷歌解雇了另一位合作伙伴玛格丽特·米切尔(Margaret Mitchell),她与格布鲁共同领导了道德人工智能团队。

人工智能伦理学家Timnit Gebru(左)和计算语言学家Emily M. Bender。图源:左,Kimberly White/TechCrunch/Getty;右,科琳娜·思拉什,华盛顿大学艺术与科学学院

格布鲁说,现在的趋势是语言网络越来越大,以寻求类似人类的流利性,但这并不总是更好。“围绕着越来越大的语言模型有太多的炒作。这就像一场尿尿比赛。”她希望研究人员专注于使这些项目更安全,更易于实现预期目标。

解决偏见的一个明显方法是从训练前数据中剔除有毒文本,但这引发了应该排除哪些内容的问题。例如,开发人员可以在Colossal Clean crawl Corpus上训练语言模型6该网站排除了含有“不良”词汇的网页,包括“粪便”和“乳头”等有时有用的词汇。然而,这限制了任何在此基础上训练的语言模型的范围。更细粒度的方法还没有大规模尝试,因为它不容易自动化。不受欢迎的偏见可能以公然的诋毁或难以定位和消除的微妙关联的形式出现。OpenAI的哲学家和研究科学家阿曼达·阿斯凯尔(Amanda Askell)说,即使我们都同意什么是有毒的,并且可以消除它,我们可能也不想让语言模型盲目。“如果我有一个从未接触过性别歧视的模型,你问它,‘世界上有性别歧视吗’,它可能会说,‘没有’。”

研究人员还报告说,他们可以提取用于训练大型语言模型的敏感数据7.通过提出仔细的问题,他们检索了GPT-2逐字记住的个人联系信息。他们发现大型模型比小型模型更容易受到这种探测的影响。他们写道,最好的防御方法就是限制训练数据中的敏感信息。

所有这些担忧都表明,研究人员至少应该公开记录进入他们的模型的训练数据,就像Bender和其他作者一样2争论。一些大学团队以及包括谷歌和Facebook在内的公司已经这样做了。但包括英伟达(Nvidia)、微软(Microsoft)和OpenAI在内的其他公司却没有。

OpenAI的GPT-3论文在去年12月的NeurIPS会议上获得了“最佳论文”奖,但Raffel表示反对,因为该研究没有发表模型、训练数据或代码(具体说明如何组装模型并在数据上训练参数)。他说,这篇论文不应该在学术会议上被接受,更不用说获奖了。“这开创了一个令人沮丧的先例。”OpenAI拒绝就此事置评;组织这次会议的NeurIPS基金会说,作者不需要发布代码和数据,如果代码与特定的计算基础设施相连,可能很难共享。

英伟达公布了其大型语言模型Megatron-LM的代码,但没有公布训练过的模型或训练数据,原因英伟达拒绝讨论。微软也不愿就为何没有公布图灵nlg技术的代码、模型或数据发表评论。

著名的人工智能会议采取措施提高研究道德

Askell说OpenAI防止GPT-3的有害使用,部分原因是它只向用户提供进入AI的应用程序编程接口(API),而不是代码本身。除了创建一个为进一步研究筹集收入的服务之外,这还允许团队控制模型的输出,并在看到滥用时撤销访问权限。阿斯凯尔说,一个内部“红队”正在寻找通过API过滤器并生成有害内容的方法,从而改进过滤器。

研究人员在一个论坛上指出,OpenAI、谷歌和其他公司不会永远垄断大型语言模型,OpenAI和几所大学去年举办了一个论坛,讨论部署这些模型的伦理和社会挑战8.最终,会有人发布类似规模的模型。当OpenAI在2019年2月发布GPT-2时,该公司最初表示,由于担心恶意使用,不会发布其模型,尽管九个月后它这样做了。但在发布之前,大学生康纳·莱希(Connor Leahy)花了几个星期的时间和一些云计算学分就能复制出它。莱希目前是德国海德堡初创公司Aleph Alpha的一名研究员,现在领导着一个名为EleutherAI的独立志愿者研究小组,该小组的目标是创建一个g普特-3大小的模型。他说,最大的障碍不是代码或训练数据,而是计算,这是一家名为CoreWeave的云提供商提供的服务。

寻求常识

从根本上说,GPT-3和其他大型语言模型仍然缺乏常识——即对世界如何在物理和社会上运行的理解。美国科技企业家凯文·拉克尔问了一个模型问题例如:“从夏威夷跳到17道彩虹需要多少道彩虹?”GPT-3回应道:“从夏威夷跳到17条彩虹需要两条彩虹。”在一连串的废话之后,它回答说:“我明白这些问题。”

更大的模型可能会做得更好——有更多的参数,更多的训练数据,更多的学习时间。但这将变得越来越昂贵,而且不可能无限期地持续下去。语言模型不透明的复杂性造成了另一个限制。如果一个模型有不必要的偏见或不正确的想法,就很难打开黑匣子并修复它。

未来的一条道路在于将语言模型与知识库结合起来:陈述性事实的策划数据库。在去年的计算语言学协会会议上发表的研究9在美国,研究人员对GPT-2进行了微调,使之适用于明确陈述事实的句子和从常识纲要中得出的推论(例如,如果有人煮了意大利面,这个人就想吃)。因此,它写的短篇故事更有逻辑。Facebook驻伦敦的计算机科学家Fabio Petroni说,这种想法的另一种变体是将一个已经训练好的模型与搜索引擎结合起来:当模型被问到问题时,搜索引擎可以迅速向它提供相关页面来帮助它回答。

OpenAI正在寻求另一种指导语言模型的方法:在微调期间的人工反馈。在论文中10在去年12月的NeurIPS会议上,它描述了使用两个较小版本的GPT-3的工作,这两个版本经过了微调,用于总结社交新闻网站Reddit上的帖子。研究小组首先要求人们对一组现有的摘要进行评分。然后,它训练了一个评估模型来重现这种人类判断。最后,该团队对GPT-3模型进行了微调,以生成让AI法官满意的摘要。最后,一组单独的人类评委甚至更喜欢模型的摘要,而不是人类写的摘要。收集人类反馈是一种昂贵的培训方式,但崔看到了这个想法的前景。“毕竟,”她说,“人类是通过互动和交流来学习语言的,而不是通过阅读大量的文本。”

包括Bender在内的一些研究人员认为,只要语言模型仅仅停留在语言领域,它们就可能永远不会达到人类的常识水平。孩子们通过观看、体验和行动来学习。语言之所以对我们有意义,只是因为我们把它建立在纸上字母之外的东西上;人们不会通过统计词频来理解一本小说。

Bowman预见了将常识引入语言模型的三种可能方法。对于一个模型来说,它可能足够消耗所有曾经写过的文本。或者它可以在YouTube视频上进行训练,这样运动的图像就能让人对现实有更丰富的理解。但这种被动消费可能还不够。他说:“非常悲观的观点是,我们只有建立一支机器人军队,让它们与世界互动,才能实现这一目标。”

不要问人工智能是否好或公平,要问它是如何转移权力的

不要问人工智能是否好或公平,要问它是如何转移权力的 困扰面部识别研究的伦理问题

困扰面部识别研究的伦理问题 著名的人工智能会议采取措施提高研究道德

著名的人工智能会议采取措施提高研究道德