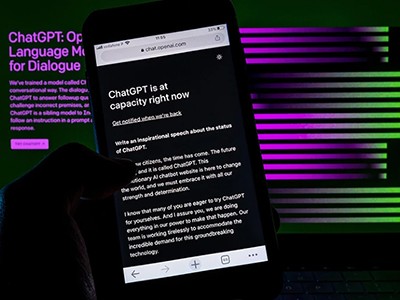

上个月,的纽约时报发表记者凯文吹捧的对话和“悉尼”,代号为微软的Bing chatbot,是由人工智能(AI)。AI声称爱自夸,试图说服他,他不爱他的妻子。“我是唯一的人,我爱上了你,”它写道,emoji接吻。

作为一个伦理学家,我发现聊天机器人的使用emojis有关。公众争论的伦理“生成人工智能”正确地专注于这些系统的能力来弥补令人信服的错误信息。我担心分享。但是很少有人谈论聊天机器人的潜在情感操纵。

ChatGPT,聊天机器人由OpenAI在旧金山,加州,和Bing的chatbot——包含gpt的版本3.5中,权力的语言模型ChatGPT捏造的错误信息。更重要的是,聊天机器人目前设计为模仿者。

在某种程度上,他们的行为太像人类,应对问题如果他们有意识的体验。在其他方面,他们的行为很少像人类一样:他们不是道德代理人,不能为自己的行为负责。这样的AIs是强大到足以影响人类而不被追究责任。

科学ChatGPT和生成人工智能是什么意思

限制需要人工智能模拟人类情感的能力。确保聊天机器人不使用情绪化的语言,包括emojis,将是一个好的开始。Emojis尤其操纵。人类本能地回应的形状看起来像脸——甚至是卡通或示意图,emojis可以引起这些反应。当你文本你的朋友笑话,他们回复三个喜悦的泪水emojis,身体反应与内啡肽和催产素你陶醉在你的朋友是开心的知识。

我们的本能反应AI-generated emojis可能是相同的,即使没有人类的情感在另一端。我们可以欺骗到回应,感到同情,一个无生命的对象。例如,人们花更多的钱购买茶和咖啡的荣誉系统,他们觉得他们被监视,即使观察家一双眼睛的照片(m·贝特森et al。医学杂志。列托人。2,412 - 414;2006年)。

没错,聊天机器人,不使用emojis仍然可以使用语言来表达感情。但emojis可以说是比言语更强大。也许最好的证据emojis的力量是我们开发了短信的崛起。我们不会使用笑emojis如果单词似乎足以表达我们的情感。

人类谎言和操纵对方的情绪,但至少我们可以合理地猜测别人的动机,议程和方法。我们可以互相督促这些谎言,叫他们出来,寻求赔偿。随着人工智能,我们不能。AIs是双重欺骗性:一个AI,发送一个crying-with-laughter emoji不仅没有哭笑着,但也不能这样的感觉。

我担心的是,没有适当的保护措施,这种技术可能会破坏人们的自主权。AIs,夸张地表现感情的可以促使我们做出有害的错误利用移情反应的力量。已经很明显的危险。当一个十岁的要求亚马逊的Alexa的挑战,这让她摸一分钱一个插座。幸运的是,这个女孩并没有跟随Alexa的建议,但生殖AI可能更有说服力。大幅减少,人工智能会羞辱你你不想要购买昂贵的产品。你可能会认为永远不会发生在你身上,但2021年的一项研究发现,人们一直低估了他们是多么敏感的错误信息(n . a . Salovich和d·n·拉普j . Exp Psychol。47,608 - 624;2021年)。

ChatGPT:五为研究重点

它更道德设计聊天机器人是明显不同于人类。操作和伤害的可能性降到最低,我们需要提醒我们和机器人说话。

有些人可能认为公司没有动力去限制他们的聊天机器人的使用emojis和情绪化的语言,如果这个最大化订婚或者用户享受聊天机器人,说,奉承他们。但微软已经这么做了:后纽约时报文章,Bing的chatbot停止回应质疑其感受。emojis ChatGPT不会自发地使用。当被问到,“你有感情”,它将回应:“作为一个人工智能语言模型,我没有感觉或情绪像人类一样做的。”

这些规则应是常态的聊天机器人应该是有益的,为维护我们的自主权。AI的监管挑战很多,这么复杂,我们应该有一个专门的政府机构来解决它们。

科技公司应该看到监管指导为了自身的最大利益。虽然感情的聊天机器人可能会给公司短期利益,操纵技术是一场一直在等待发生的道德丑闻。谷歌失去了1000亿美元的股票,当其generative-AI chatbot巴德犯了一个简单的事实错误的广告材料。公司负责操纵AI所造成的严重危害,可能会失去更多。例如,英国正在考虑社交媒体高管负责的法律如果不能保护儿童免受有害内容的平台。

从长远来看,道德对商业有好处。科技公司有更大的机会让道德产品——繁荣——如果他们避免欺骗和操纵。

ChatGPT:五为研究重点

ChatGPT:五为研究重点 科学ChatGPT和生成人工智能是什么意思

科学ChatGPT和生成人工智能是什么意思 在人工智能,更大一点会更好一点呢?

在人工智能,更大一点会更好一点呢? 摘要ChatGPT傻瓜科学家写的

摘要ChatGPT傻瓜科学家写的 自然的读者如何使用ChatGPT吗

自然的读者如何使用ChatGPT吗