文摘

COVID-19流感大流行的影响之一是快速增长和变化的出版物通知临床医生、研究人员、政策制定者、和病人的健康、社会经济和文化影响的大流行。手工管理这些信息流并不可行。自动问答可以快速给用户带来最凸点的注意。利用收集的科学文章、政府网站、相关新闻,社交媒体策划职位,和问的问题研究人员,临床医师,和公众,我们开发了一个数据集探索自动问答多个利益相关者。分析各利益相关者的问题表明,尽管专家和公众的信息需求可能重叠,满意的对这些问题的回答往往来自不同的信息来源或从不同的方法来回答一代中获益。我们相信这个数据集有可能支持问答系统的开发不仅对流行问题,但对其他领域有不同法律或金融等专业知识。

测量(s) |

文本 |

技术类型(年代) |

自然语言 |

背景和总结

COVID-19大流行凸显了两个主要问题提供可靠的特定领域的信息:(1)信息提供者正在迅速生成大量的潜在的重要信息,可能永远不会达到他们的目标受众,和(2)信息搜索者很难找到答案,具体的和不断变化的信息需求快速增长和变化的通信。这两个问题实际上是一个硬币的两面,和使信息更容易发现减少潜在的重要信息继续忽视它的目标受众。信息检索(IR)系统(例如,像Google这样的搜索引擎,Bing,或PubMed)现在信息寻求和不可分割的一部分的一个主要工具用来满足信息需求。大流行性流感暴露的主要问题依赖于信息检索系统在压力和快速变化的情况下:现有解决方案检索成百上千的文件——其中许多可能不是相关用户的特定信息的需要。这种不必要的增加信息所需的时间和精神努力工作的人,必须阅读这些文档信息需求找到答案。问答是一个研究领域旨在缓解这个问题的相关信息从数以千计的文档将最显著的相关文件立即集中,节省时间和高亮显示的信息可能会被忽视。

为此,我们提出一个新的问答数据集:Epi黛米c QA(EPIC-QA),旨在评估自动方法对疾病COVID-19回答特定的问题,其因果病毒SARS-CoV-2相关冠状病毒,建议应对流感大流行。虽然COVID-19一直是推动大量的新兴科学研究和调查,应对COVID-19对公众提出了问题。冠状病毒的快速增加文学和发展社区指南响应创建一个具有挑战性的负担不仅为科学和医学社区公众保持更新的最新发展。因此,数据集的目标是评估系统的能力,提供及时和准确的专家级的答案所预期的科学和医学社区以及答案适合大众的语言。EPIC-QA数据集包含(a) COVID-19问题从不同的涉众需要收集信息,(b)文件——包括科研文章适合专家以及相关的新闻,社会媒体,和页面的权威网站面向公众,和(c)对这些问题的回答从文档中提取的数据集和系统地进行注释和评判专家。

只有少数公开的与健康有关的QA数据集存在。在信息检索方面,CORD-191是使用最广泛的文档集合,包含文件PubMed、研究文章从世界卫生组织(世卫组织),预印从bioRxiv medRxiv arXiv, SemanticScholar。然而,CORD-19并不提供问题或答案。COVID问答,CovidQA2提供124 question-article-answer三胞胎从85篇文章;COVID-Q3由1690个问题(没有答案)注释为15个类别和207集群;医疗问题对(MQP)4包含3048对医疗问题注释是COVID-19相似或相异的常见问题;的协同任务2021 BioASQ挑战(http://www.bioasq.org/)包括四个轮的二进制、似是而非的列表,根据CORD-19收集和总结问题;和2021年TREC卫生错误信息跟踪(https://trec-health-misinfo.github.io/)包括主题关注COVID-19注释说明文件是否与主题的回答。额外的自然语言处理的详细审查资源COVID-19,看到陈等。(2021)5。相比之下,EPIC-QA,它既包含面向公众和专家提供文档,是唯一的数据集探索答案的区别适用于公众和那些合适的专家。它是唯一的数据集设计包括各种各样的每个问题的惟一可能的答案。

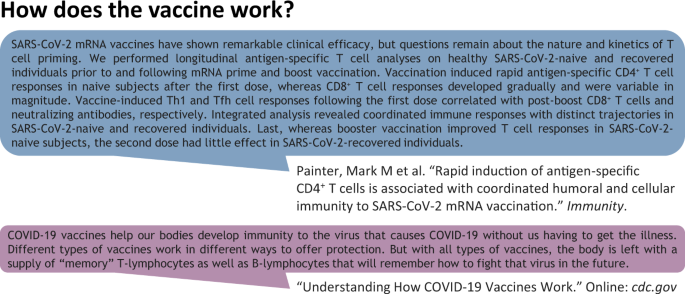

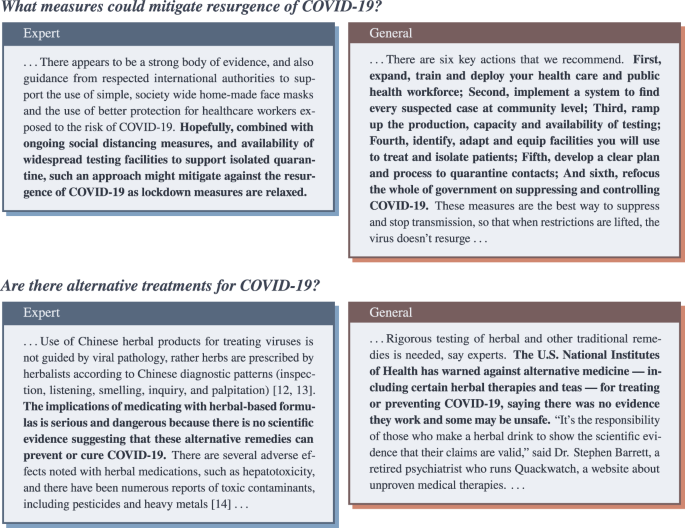

虽然有重叠的类型的不同利益相关者要求的问题,这些问题的答案应该根据用户的背景知识不同。例如,考虑一个简单的问题见图。1,疫苗是如何工作的呢?在专家眼中,答案应该指明确切的机制和途径。相比之下,普通大众的一员,这条信息太涉及可能导致混乱;相反,一个更合适的答案将提供一个更一般的概述的作用的疫苗和一个高层次的描述机制。上下文中的COVID-19迅速加速知识的管理专家和一般水平之间的二元性信息是更重要的。我们希望EPIC-QA数据集将刺激研究在自动问答不仅支持COVID-19提供优质及时的信息,但也支持的发展可概括的方法来满足信息需求,面对不同层次的专业知识对其他领域,如一般医疗、金融、或法律。

方法

问答系统传统上包括两个主要步骤:一个信息检索检索步骤,相关文件对于一个给定的问题,和一个答案抽取步骤,相关段落或答案中确定检索文档并提取初始或用于合成一个答案。最近,端到端问答系统已经开发出来的(深)神经网络训练,共同确定相关的段落和提取这些段落的答案。因此,EPIC-QA数据集包含两个集合旨在促进研究(一)答案提取或(b)端到端的问题回答,分别。问题的答案抽取数据集改编自TREC-COVID的查询检索共享任务(https://ir.nist.gov/trec-covid),与相关性的相关注释的任务。端到端数据集,我们引入一个新的问题,并提供相关文件,回答注释没有关联检索相关性排名。这两个集合可单独或协同研究之间的关系文档检索和答案抽取。两个集合包含三个组件:

- 1。

两套manually-produced问题,要求公众以及另一个由专家问有关COVID-19;

- 2。

相关文档的集合COVID-19包括出版和预印生物医学研究的文章以及从政府网站获得的文件,新闻,和社交媒体,自动解析到的句子;和

- 3所示。

manually-produced回答每个问题的不同的列表以及一组相关文件摘录与手动能注释语句表明这答案,如果有的话,每个句子都证明了这一点。

促进答案抽取研究,相关问题在答案抽取数据集是另外一组相关文件可能被一个最优的搜索引擎检索到,而在端到端数据集的问题。我们详细的过程产生了这些组件。

产生的问题

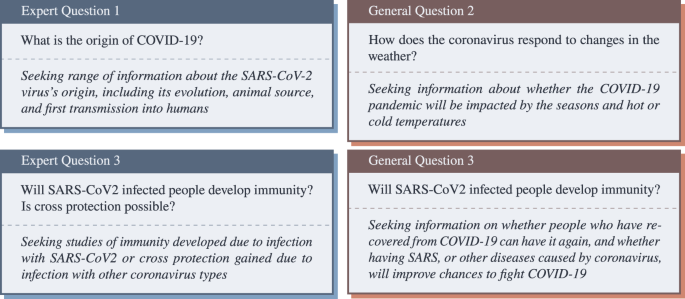

两组的问题包括:一个用于的专家级的问题和一般公众。通过设计,许多专家和消费者的问题重叠在集中精力促进这两种类型的利益相关者之间的比较。答案抽取的数据集,我们适应评估的主题第四轮TREC-COVID (https://ir.nist.gov/covidSubmit)。大多数这些问题源于与医疗在线用户的交互。额外的科学问题是基于开发小组讨论从美国国立卫生研究院(NIH) COVID-19特殊利益集团,俄勒冈健康与科学大学临床医生,问的问题和响应公众呼吁的问题。TREC-COVID主题包括的专家级的背景描述用户的信息需求;促进面向公众产生public-friendly背景为每个问题回答我们的问题。我们提供的文档级别的相关性判断TREC-COVID评估中产生的这些问题。问题和答案抽取收藏品包括45专家42公众与文档级别的相关性判断的问题。端到端集合,一套新的开发30专家和30公众问题,其中没有一个在TREC-COVID进行评估;因此,这些问题不跟文档级别的相关性来判断。例子问题提供了无花果。2。虽然这些看似一个小数量的问题(87年总回答提取问题和60)端到端的问题,每个问题与多个答案,和45 - 60通道的注解在句子层面上显示的答案,如果有的话,都包含在每个句子。

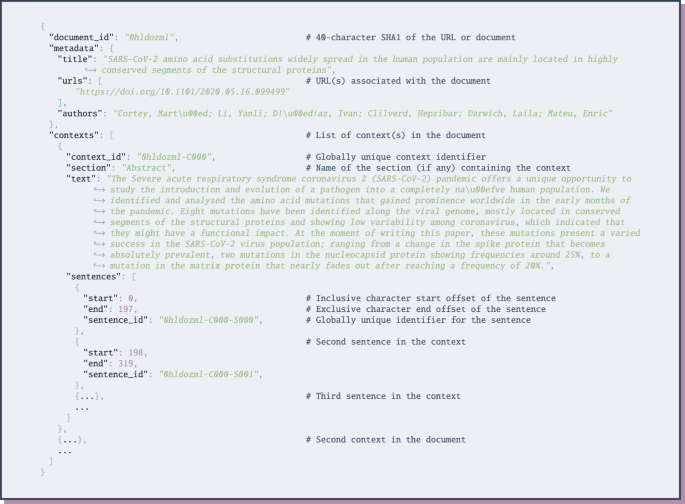

收集文件

每个文档在EPIC-QA包括明确预定义的上下文(概括段落或部分)和句子边界。同时支持的专业知识水平,文档集合包含两个部分:科学和医学研究,面向公众的在线文档。

科学和研究文件

我们适应的集合COVID-19开放研究生物医学文章发布数据集的挑战(CORD-19)6。数据集是由艾伦研究所陈AI与扎克伯格倡议,乔治敦大学的安全中心和新兴技术,微软研究院,以及国家医学图书馆——国家卫生研究院配合白宫科技政策办公室。CORD-19收集包括公共医学中心(PMC)的一个子集的文章以及预印bioRxiv和medRxiv。上下文在这个集合对应于自动识别段落文章的摘要,或者主要文本。我们包括两个快照CORD-19:快照从6月19日,2020年与答案提取收集、使用和快照从10月22日,2020年,用于端到端集合。

面向公众的文档

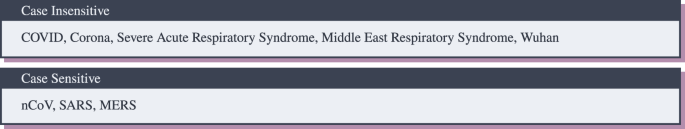

我们包括的一个子集的文章使用的消费者健康信息问答(CHIQA)服务的美国国立医学图书馆(NLM)7。这个集合包括权威的文章来自疾病控制和预防中心(CDC);遗传和罕见的疾病信息中心(加尔省);遗传学家参考(GHR);Medline Plus;国家过敏症和传染病研究所(NIAID);和世界卫生组织(世卫组织)。上下文在这个集合对应段落或部分显示的HTML标记的文档。所有的文章都是过滤COVID-19内容在图中使用的术语。3。在端到端集合,我们还包括265个Reddit线程以及CommonCrawl新闻抓取的一个子集(CCNC) 1月1日至4月30日,2020年,用于TREC卫生错误信息跟踪(https://trec-health-misinfo.github.io/)。为了避免错误,我们只考虑从heavily-moderated Reddit的威胁/ r / askscience社区被标记为有关COVID-19、医学、生物学、人体(也包含在无花果COVID-19术语。3)。同样,为了避免不相关的页面和错误信息,国家气候变化委员会文件被顶级域名(即过滤。“。gov”或“edu”),使用前100名一级域名以萨尔萨舞8,网页排名9,点击10;剩下的页面被过滤COVID-19内容在图中使用的术语。3。

生产的答案

为EPIC-QA数据集产生的答案时,我们的目的是探索答案的景观断言在文档集合。因此,我们考虑任何声明,回答了这个问题作为一个“答案”不管答案是准确当时文档撰写或给定的当前信息。答案在这个数据集的目的是作为中间步骤的虚幻一想探索所有的答案提供的文档集合,正确的答案以及错误的答案,人们可能发现自己。答案是由应用多个自动问答系统的问题EPIC-QA识别上下文,可能回答这个问题技术验证更多的细节)。这些上下文汇集问题和深度的五个专家的深度8对公众的提问,每个问题导致大约45 - 60上下文。人类评估阅读这些检索上下文和判断。具体来说,17个医学索引器5到30年的经验在国家医学图书馆的分析集中在两轮上下文:(1)答案一代轮,紧随其后的是(2)一个能回答语句注释。注释进行医学索引器的一部分在国家医学图书馆公务。

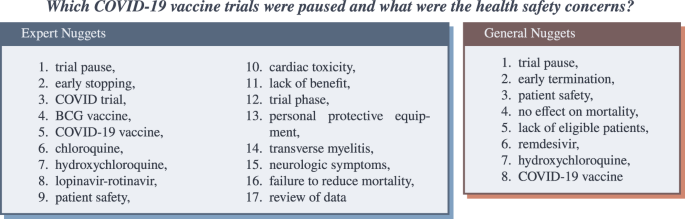

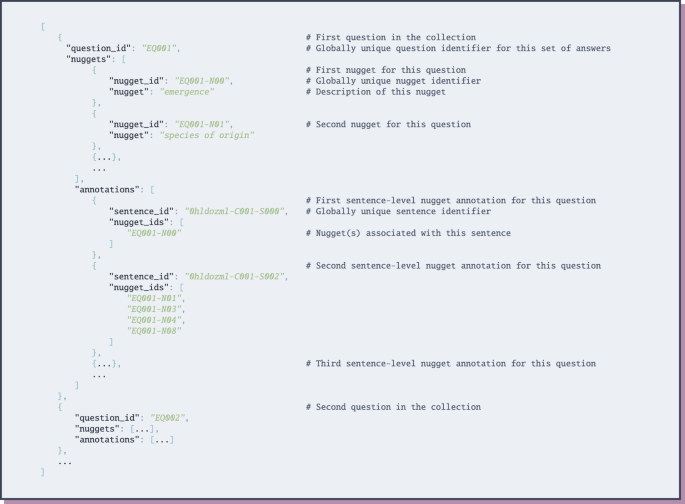

回答关键代

在第一轮选举中,评估人员访问的上下文确定给定问题以及一个特别在文档集合的搜索引擎。答案代轮的作用是评估探索发现的情况下自动问答系统以及文档集合来确定一组原子“事实”,回答这个问题需要根据问题的信息或背景(见图。2)。如vooorhees (2005)11,我们将这些事实掘金,这样每一个金块表明一个事实的评估员可以做出二选一的决定是否一个上下文或句子包含这一事实。例子掘金,生产问题”COVID-19疫苗试验暂停,卫生安全问题是什么?图中所示。4:缺乏利益,患者安全等等。这一轮的主要作用是创建一个回答的关键问题包括汇集的掘金识别上下文或评估员的特殊搜索的集合。搜索引擎来帮助评估探索主题和识别提供了掘金的评估员可能意识到的问题的先验知识,但可能没有被包含在任何集中的上下文。评估员不会详尽识别所有可能的珍品;,而他们的目的是识别重要的自由裁量权(评估)掘金,他们觉得应该包含在回答主要基于他们对问题的理解。

能回答注释语句

在第二轮,答案关键(掘金)是固定的。陪审员被给予相同的池上下文用于圆。这一次,他们被要求每一个上下文表示注释所有句子,金块(s)(如果有的话)是由每个句子。例如,对于问题”COVID-19疫苗试验暂停,卫生安全问题是什么?“句子”[我]n最近出版的光……缺乏安全性和有效性的HCQ COVID-19治疗病人,团结的执行组试验决定实施一个临时暂停HCQ臂的试验作为一项预防措施,而安全数据被审查”包含专家掘金标注为:COVID试验,审讯暂停,缺乏利益,羟氯喹,患者安全,审查的数据。

数据记录

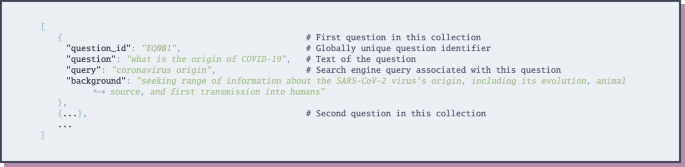

流行的问题回答(EPIC-QA)数据集可以通过开放的科学基金会(OSF)https://doi.org/10.17605/OSF.IO/VNYK812。EPIC-QA数据集的问题提供了四个文件后,JSON格式见图。5:

ae / expert_questions.json包含45的专家级问题产生答案提取集合;和

ae / general_questions.json包含42提问答案提取收集产生的公众。

e2e / expert_questions.json端到端集合包含30的专家级的问题产生;和

e2e / general_questions.json包含30个问题公众产生的端到端集合。

文件包含在EPIC-QA数据集分别提供答案提取和端到端集合。对于每一个集合,每个文档是作为一个单独的JSON文件提供的,坚持JSON模式见图。6:

ae / cord19 /包含129069个JSON文件,每个文件对应于生物医学研究的文章从6月19日,2020 CORD-19的快照;和

ae /一般/包含925个JSON文件,每个文件对应一个政府或卫生机构网站爬6月10日,2020年。

e2e cord19 /包含236035个JSON文件,每个文件对应于生物医学研究的文章从10月22日,2020 CORD-19的快照;

e2e ask_science /最初是空的(用户保留版权在每一个他们的评论和文章在Reddit,直接阻止我们重新分配他们的数据),但是,它可以填充使用Python脚本脚本/ populate_reddit.py263年创建JSON文件,每个文件对应一篇2019年12月1日和10月29日2020年/ r / askscience社区在Reddit标记由社区版主COVID-19对应,健康、医学或生物学,包含一个COVID-19关键词图所示。3

e2e ccns_trec /包含114645个JSON文件,每个文件对应一个HTML-parsed网站CommonCrawl新闻中使用的子集TREC错误跟踪包含图中所示的COVID-19关键词之一。3;和

e2e / chqa包含2739个JSON文件,每个对应一个10月9日,2020年HTML-parsed web页面的快照隶属于美国国立卫生研究院,疾控中心,或者包含一个COVID-19关键字的图所示。3。

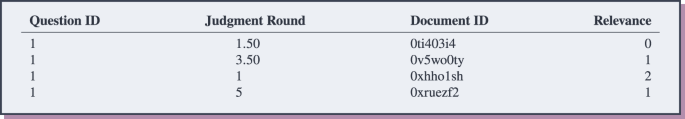

最后,答案提供了四个文件,对应答案提取和端到端收藏专家和公众的问题。对于每一个问题:每个答案(即。,nugget) is associated with the set of sentence-IDs that nugget was identified within, as shown by the JSON schema in Fig.7。答案提取收集另外包括文档级别的相关性的判断trec_eval(https://github.com/usnistgov/trec_eval)格式,见图。8。注:由于时间和预算限制,只有21个专家和17公众问题与答案答案提取收集充分解释。最后,EPIC-QA还包括所有参与者提供的排名和答案相关的文本分析EPIC-QA评估会议(TAC,请参阅技术验证详情),以及一个“理想”的排名基于我们的评估员的回答的答案注释。

技术验证

验证EPIC-QA数据集,我们组织了一个社会评价在2020年文本分析会议(TAC)的参与者提供的数据集(没有答案),并要求提交排名1000相关的列表段落对于每一个问题,在一段被定义为一个连续的序列的句子从一个上下文。我们第一次评估答案提取收集和评估的判断产生额外的数据提供参与者的后端到端评估。

我们鼓励团队探索多样化的答案而不是返回许多段落提供最常见的或明显的答案。为此,我们验证EPIC-QA使用修改后的版本的归一化累积获得折扣13(NDCG),我们称之为规范化的折扣新奇得分(ndn)。重要的是,累计获得NDCG计算文档独立于其他检索文档,新奇的分数(NS)措施的信息通道,没有见过之前在排名的文章列表。形式上,我们定义了新奇的分数,NS,通道p为:

在哪里\ ({n} _ {} \)的数量是小说答案在文章p和\ ({n} _{年代}\)是通过句子的数量(一个答案被认为是小说如果没有包含在任何earlier-retrieved通道问题。)。这个指标确保识别段落必须简短(即。,they must express a novel nugget in as few sentences as possible) and they should not contain sentences with only nuggets provided in previous answers. As in NDCG, we (A) compute the discounted cumulative novelty score, DNS, by adjusting the novelty score, NS, of each answer retrieved up to rank\ (l \)使用对数换算系数,和(b)正常化的DNS排名\ ({\ boldsymbol{一}}={一}_ {1}\ cdots{一}_ {l} \)最优的DNS或理想的排名可能的答案,\ (\ widehat {{\ boldsymbol{一}}}\)可能已经获取了这个问题(基于所有产生的相关性判断问题)。在我们的评估中,我们使用定向搜索宽度10来确定答案的理想的排名。ndn我们报告三个不同的版本,不同的句子是如何计算在计算\ (NS \):

- 1。

确切的重视文章,包含尽可能多的小说掘金在尽可能少的句子,这样\ ({n} _{年代}\)正好等于通过句子的数量;

- 2。

部分,使用的句子数量来表达小说掘金并不认为,例如,\ ({n} _{年代}\)是句子的数量与小说掘金如果所有句子合并成一个单一的句子前计数;和

- 3所示。

放松,句子用来表达小说的数量或以前见过掘金并不认为,例如,\ ({n} _{年代}\)是句子的数量如果所有句子包含小说掘金被合并成一个单一的句子,和所有的句子包含以前见过掘金被合并成一个单独的一句话计数。

评估脚本中包含的数据集。

答案提取验证

总共有17提交收到8团队专家的问题,和10为公众提交的六支球队的问题,如表所示1。我们观察到,ixa和IBM提交专家问题而表现出最好的性能HLTRI提交之后,获得了最高的性能IBM从公众的问题。的ixa神经语言模型由SciBERT运行使用142.0调整的球队15一般领域问答数据;他们的第二和第三QuAC运行另外调整16数据集,一个对话的问题回答涉及人群工人和老师讨论一段文本。有趣的是,他们的第三个和表现最好的运行依赖于自己的信息检索系统,而不是TREC-COVID期间产生的相关标签。IBM的三分忽略了包括相关标签,用三种不同乐团的弹性搜索通过检索和/或神经评估方法。他们最后的运行是一个组合的整体信息检索罗伯塔的分数和成绩17调整对自然的问题18,一般域问答数据集来自谷歌搜索查询和维基百科文章。HLTRI依靠BioBERT运行19排名的神经通道应用于句子带状疱疹(运行的多个相邻句子)使用TREC-COVID相关标签。整体,而相关性判断为公众帮助回答问题,其影响是不太清楚的专家级的问题,建议文件可能是有关从信息检索的角度来看,尽管没有明确可引渡的回答这个问题。

端到端验证

端到端问题,总共有16个提交收到7团队专家的问题,和12提交从五个团队收到了公众的提问,如表所示2。对于专家的问题,HLTRI不过,通常运行表现出最好的性能Yastil_R的第一个运行的表现HLTRI第一次运行。HLTRI运行依靠BM25-based信息检索步骤20.,一个BERT-based紧随其后21排名,最后一步暗含受承认的问题22。第一次运行从Yastil_R依赖于一个信息检索的步骤通知BM25, DeepCT23,科尔伯特24,docTTTTTquery25,紧随其后的是一个答案抽取步骤依赖伯特MS-MARCO微调26。当看着公众,性能也体现在顶部h2loo的运行涉及BM25-based检索步骤其次是逐点和双向评估使用T5,和最后一个sentence-re-ranking步骤使用最大边际改善相关性(MMR)多样性。

当比较答案提取和端到端验证的结果,很明显,团队通常表现要好于端到端的尽管端到端是一个更具挑战性的问题。这可能解释这一事实的答案抽取阶段TAC的挑战是设计和提升为初步数据收集,而端到端问题提出了作为评价主轮。我们的信念,提高端到端性能评价表明,团队花了更多的研究工作任务比答案提取任务。

总的来说,团队能够产生令人满意的答案使用各种方法基于EPIC-QA数据。有趣的是,专家和公众之间的排名变化性能也表明,一刀切的并不适合所有人,而且系统需要更好的考虑不同的利益相关者,如专家和公众。

回答验证

无花果。9提供了顶尖专家和一般表现最佳答案提取的专家(hltri的第三个运行)和公共(h2oloo第二运行)系统开发使用EPIC-QA数据集。总的来说,我们可以看到,系统开发使用这个数据集获得合理的结果:他们能够识别不同,简洁,合理完整的答案,可以满足专家和公众。这表明EPIC-QA数据集可以用来训练可靠的问答系统答案epidemic-related由不同利益相关者所提出的问题。

印象

我们提出疫情问答(EPIC-QA)数据集,设计评估和关注的重要问题回答问题COVID-19从新兴的文学,以及探索所期望的答案不同的涉众之间的差异。EPIC-QA数据集由两部分组成,旨在促进答案提取或端到端问答的研究,分别与每个部分包括(a)两组问题来自两种类型的利益相关者(专家和公众),(b) manually-produced这些问题的答案从文档中提取数据集和系统由人类专家的注解和判断,和(c)文档收集包括科研文章适合专家以及相关的新闻,社会媒体,和页面从权威网站面向公众。技术验证通过文本分析社区评估会议(TAC)表明,系统可以在集合中发现有用的答案,这答案(和支持段落)的预期不同的涉众可以大幅改变。我们相信我们的技术验证表明探索答案的不同景观的重要性,网上对健康问题,显示了不同程度的理解会计的重要性,当确定满意的健康问题的答案,并希望这个数据集将价值的研究人员探索答案的多样性,多个利益相关者,或开放式医疗问题回答。

使用笔记

我们提供了指示如何处理这个数据集的数据集提供的README文件。自动系统开发使用该数据集的描述是可用的https://tac.nist.gov。

代码的可用性

准备使用的代码EPIC-QA提供数据集https://github.com/h4ste/epic_qa和一个Python脚本计算评价指标在这个手稿的技术验证部分提供的数据集。

引用

王,L . L。等。CORD-19: COVID-19开放研究的数据集。在学报第一车间在2020年COVID-19 NLP的ACL(在线计算语言学协会,2020年)。

唐,R。等。快速引导covid-19的问答数据集(2020)。2004.11339

魏,J。,Huang, C., Vosoughi, S. & Wei, J. What are people asking about COVID-19? a question classification dataset. In学报第一车间在2020年COVID-19 NLP的ACL(在线计算语言学协会,2020年)。

McCreery c, H,平常。Katariya, N。Kannan,。,Chablani, M. & Amatriain, X.有效转移学习识别类似的问题:匹配用户问题COVID-19常见问题解答3458 - 3465(计算机协会,纽约,纽约,美国,2020)。

陈,Q。等。人工智能在行动:解决covid-19流行病和自然语言处理。生物医学数据科学的年度审查4,313 - 339,https://doi.org/10.1146/annurev - biodatasci - 021821 - 061045(2021)。PMID: 34465169。

王,L . L。等。Cord-19: covid-19开放研究的数据集。ArXivabs / 2004.10706(2020)。

Demner-Fushman D。,Mrabet, Y. & Ben Abacha, A. Consumer health information and question answering: helping consumers find answers to their health-related information needs.美国医学协会杂志》上27,194 - 201,https://doi.org/10.1093/jamia/ocz152(2019)。https://academic.oup.com/jamia/article-pdf/27/2/194/32500415/ocz152.pdf。

Lempel r &莫兰s莎莎:链接结构分析的随机方法。ACM反式。正,系统。19,131 - 160,https://doi.org/10.1145/382979.383041(2001)。

页面中,L。,Brin, S., Motwani, R. & Winograd, T. The pagerank citation ranking: Bringing order to the web. Tech. Rep.,斯坦福InfoLab(1999)。

jonkleinberg, j . m .权威超链的环境。杂志的ACM (JACM)46,604 - 632 (1999)。

vooorhees,大肠使用问题系列对问答系统的有效性进行评估。在人类语言技术会议和研讨会论文集在自然语言处理的经验方法,299 - 306(计算语言学协会,温哥华,不列颠哥伦比亚,加拿大,2005)。

古德温,t & Demner d流行问答(EPIC-QA),开放科学框架,https://doi.org/10.17605/OSF.IO/VNYK8(2022)。

Jarvelin, k & Kekalainen j .累积gain-based评价红外技术。ACM反式。正,系统。20.,422 - 446,https://doi.org/10.1145/582415.582418(2002)。

Beltagy,我。,K。&Cohan, A. SciBERT: A pretrained language model for scientific text. In学报2019年会议上实证方法在自然语言处理和第九届国际联合会议上自然语言处理(EMNLP-IJCNLP),3615 - 3620,https://doi.org/10.18653/v1/d19 - 1371(计算语言学协会,香港,中国,2019)。

Rajpurkar, P。,Jia, R. & Liang, P. Know what you don’t know: Unanswerable questions for SQuAD. In美国第56计算语言学协会年会(卷2:短论文),784 - 789,https://doi.org/10.18653/v1/p18 - 2124澳大利亚墨尔本(计算语言学协会,2018年)。

崔E。等。QuAC:问答在上下文。在学报2018年大会在自然语言处理的经验方法,2174 - 2184,https://doi.org/10.18653/v1/d18 - 1241(计算语言学协会,布鲁塞尔,比利时,2018)。

刘,Y。等。Ro{伯特}:{伯特}pretraining强劲优化方法(2020)。

Kwiatkowski, T。等。自然问题:问题回答研究的基准。计算语言学协会的事务7,452 - 466,https://doi.org/10.1162/tacl_a_00276(2019)。

李,J。等。BioBERT: pre-trained生物医学生物医学文本挖掘语言表征模型。生物信息学36,1234 - 1240,https://doi.org/10.1093/bioinformatics/btz682(2019)。https://academic.oup.com/bioinformatics/article-pdf/36/4/1234/32527770/btz682.pdf。

Robertson s E。等。霍加皮trec-3。1995年学报第三文本检索会议(TREC)109年(1995)。

Devlin, J。,Chang, M.-W., Lee, K. & Toutanova, K. BERT: Pre-training of deep bidirectional transformers for language understanding. In学报2019年大会北美的计算语言学协会章:人类语言技术,第一卷(长时间运行和短论文),4171 - 4186,https://doi.org/10.18653/v1/n19 - 1423(计算语言学协会,明尼阿波利斯,明尼苏达州,2019)。

电影A b & Demner-Fushman d question-entailment方法来回答问题。BMC生物信息学20.1,(2019)。

戴,z &卡兰,J。环境敏感词权重为第一阶段通过检索1533 - 1536(计算机协会,纽约,纽约,美国,2020)。

哈达,o . & Zaharia M。科尔伯特:高效和有效的通过搜索通过情景化后期交互在伯特39-48(计算机协会,纽约,纽约,美国,2020)。

Nogueira, R。,Lin, J. & Epistemic, A. From doc2query to doctttttquery.在线预印本(2019)。

阮,T。等。马可女士:人类阅读理解数据集生成的机器。在Besold, t·R。誉为,。,d’Avila Garcez, A. S. & Wayne, G. (eds.)《认知计算:研讨会整合神经和象征性的方法2016共存与30年会在神经信息处理系统(2016年捏),巴塞罗那,西班牙,2016年12月9日卷,1773CEUR研讨会论文集(CEUR-WS.org, 2016)。

确认

该手稿的内容完全是作者的责任,并不一定代表官方观点的美国国立卫生研究院(NIH)和国家标准与技术研究所(NIST)。某些商业设备、仪器或材料确定本文为了充分指定实验过程。这样的身份并不打算意味着推荐或认可NIST NIH,也不是有意暗示标识的材料或设备必然是最好的可用的目的。这项工作得到了校内研究项目在美国国家医学图书馆,国家卫生研究院。我们想感谢山姆Skjonsberg和马克诺伊曼的帮助与注释平台,罗伯·古兹曼领导注释工作以及Annemieke van der Sluijs,凯西史密斯,黛博拉·惠特曼,多萝西陈,大卫•Cissel Farzaneh Badiei, Funmi Akhigbe,珍妮丝的病房里,詹妮Rewolinski, Keiko漫画家关谷神奇,梅勒妮休斯敦,塞斯·罗杰斯,尼克•Miliaras奥列格•Rodionov奥尔加·Printseva罗伯•古斯曼和苏珊施密特为创建答案键及其注释工作。最后,我们感谢奥黛丽通她的手稿的初步审查。

资金

开放获取的资金由美国国立卫生研究院(NIH)。

作者信息

作者和联系

贡献

T.R.G. D.D.F.起源研究,起草了手稿,分析结果,收集non-CORD-19数据,开发了评估工具,相关的主要组织者在TAC共享任务。K.L.和L.L.W.准备调整CORD-19快照用于EPIC-QA和注解的接口开发。H.T.D. I.M.S.组织TAC,团队提交和池处理,建议在掘金的作用评价。系所有作者回顾了手稿,在TAC共享任务。

相应的作者

道德声明

相互竞争的利益

作者宣称没有利益冲突。

额外的信息

出版商的注意施普林格自然保持中立在发表关于司法主权地图和所属机构。

权利和权限

开放获取本文是基于知识共享署名4.0国际许可,允许使用、共享、适应、分布和繁殖在任何媒介或格式,只要你给予适当的信贷原始作者(年代)和来源,提供一个链接到Creative Commons许可,并指出如果变化。本文中的图片或其他第三方材料都包含在本文的创作共用许可,除非另有说明在一个信用额度的材料。如果材料不包括在本文的创作共用许可证和用途是不允许按法定规定或超过允许的使用,您将需要获得直接从版权所有者的许可。查看本许可证的副本,访问http://creativecommons.org/licenses/by/4.0/。

关于这篇文章

引用这篇文章

西奥多•古德温。,Demner-Fushman D。,K。et al。自动问答多个利益相关者,流行问答集。科学数据9432 (2022)。https://doi.org/10.1038/s41597 - 022 - 01533 - w

收到了:

接受:

发表:

DOI:https://doi.org/10.1038/s41597 - 022 - 01533 - w