摘要

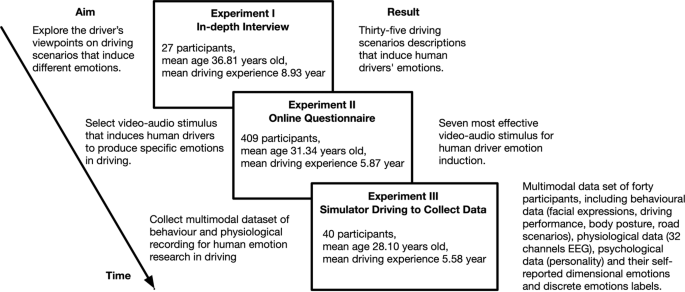

人类的情感是日常任务中不可或缺的一部分,现在驾驶就是一项典型的日常任务。在驾驶任务中创建多模态人类情感数据集是人类情感研究的重要一步。我们进行了三个实验来收集人类情绪的多模态心理、生理和行为数据集(PPB-Emo)。实验一共招募27名参与者,采用深度访谈法探讨驾驶员对诱发不同情绪的驾驶场景的看法。实验二招募409名参与者,通过问卷调查获取诱发人类驾驶员产生特定情绪的驾驶场景信息,并以此为依据选择视频-音频刺激材料。在实验III中,招募了40名参与者,收集了所有参与者在280次驾驶任务中的心理数据、生理数据以及行为数据。PPB-Emo数据集将在很大程度上支持驾驶任务中的人类情绪分析。此外,PPB-Emo数据集也将有利于其他日常任务中的人类情感研究。

| 测量(s) | 脑电图测量•驾驶行为测量•面部表情、身体手势和道路场景测量•情绪和个性 |

| 技术类型(年代) | 脑电图(EEG)•驾驶模拟器•视觉观察法•自述量表 |

背景与总结

人类的情感是日常生活不可或缺的一部分,影响着各种认知能力1,2.具体来说,它们可以将注意力引导到环境的关键特征上,优化感官摄入,调整决策,准备行为反应,促进社会互动,增强情景记忆3.,4.因此,人类的情绪影响着人类每天经历的不同任务,如学习、睡眠、驾驶、娱乐。开车现在是一项典型的日常工作5,6.据统计报告显示,全球人均每天驾驶时间超过1小时7,8,这也伴随着驾驶任务中人类负面情绪造成的严重伤害、死亡和相关成本9,10.长期以来,如何通过研究驾驶任务中人的情绪来降低由情绪引起的事故风险,一直是心理学、生理学、工程学、人体工程学等诸多领域的重要研究课题,并得到了广泛的研究11,12,13,14,15.

随着传感、机器学习和计算系统的发展,大量新兴的智能车辆被开发出来,与交通网络中的车辆、行人、基础设施和云连接16,17.因此,智能汽车已经成为承载丰富功能和服务的智能移动终端18,19,不仅拓展和深化了人机交互的范围,而且为进一步研究驾驶任务中的人类情感,即情感感知的人机交互,提供了一个新兴的、具有挑战性的研究领域20.,21.具体而言,情感感知人机交互包括多模态情感检测和调节,这将增强人类在驾驶任务中的安全性,也将提高他们的舒适性和驾驶体验22,23.研究驾驶任务中情感感知的人机交互需要跨学科知识,包括认知心理学、脑科学、人为因素、汽车工程、情感计算等19,24.可穿戴设备等最新的技术创新促进了对情绪的研究,导致越来越多的研究调查驾驶过程中某些情绪的积极或消极影响(例如愤怒)25、悲伤26).为了测量人类的情绪,心理学研究揭示了情绪的多模态表达27.此外,情感计算的研究主要集中在基于不同情绪表达的人类情绪状态的检测上6,28.此外,视觉和听觉界面等人机界面会影响人在驾驶任务中的情绪15,29.

为了研究驾驶任务中的人类情感,研究人员需要丰富且可重复的数据集30..在过去的十年里,研究人员在驾驶中共享了多个人类情感数据集。表格1总结了调查论文中捕获驾驶员信息的数据集。虽然这些数据集为人类情感研究的成功支持做出了贡献,但仍然缺乏用于驾驶中人类情感研究的多模态数据集(包括心理、生理和行为数据)。因此,创建驾驶中的多模态人类情感数据集是情感感知人机交互研究的重要一步。然而,据我们所知,目前还没有公开的驾驶任务中人类情绪的多模态数据集。

在这里,我们提出了驾驶任务中人类情绪的心理、行为和生理数据(PPB-Emo)的多模态数据集。如图所示。1,我们进行了三个实验来收集PPB-Emo数据集。实验一招募27名参与者,采用深度访谈法探讨驾驶员对诱发不同情绪的驾驶场景的看法,并将调查结果用于编制问卷。实验二招募409名参与者,通过问卷调查获取诱发人类驾驶员产生特定情绪的驾驶场景信息,并以此为依据选择视频-音频刺激材料。实验三采用实验一和实验二中选取的视频音频片段作为人类驾驶员情绪诱导的刺激材料。在实验III中,招募40名参与者,收集所有参与者在280次驾驶任务中的心理数据(自我报告的维度情绪和离散情绪、人格特征)和生理数据(脑电图)以及行为数据(驾驶行为、面部表情、身体姿势、道路场景)。PPB-Emo数据集将在很大程度上支持驾驶任务中人类情绪-认知-行为-个性的分析,以及情绪检测算法和自适应情绪调节策略的研究。据我们所知,PPB-Emo数据集是目前唯一公开的驾驶任务中人类情绪的多模态数据集,PPB-Emo数据集也将有益于其他日常任务中的人类情绪研究。

方法

道德声明

这项研究是根据《赫尔辛基宣言》及其后来的修正案的要求进行的。本研究的内容和程序经重庆大学肿瘤医院伦理委员会注意并批准(批准文号:2019223)。

所有参与者在参加本研究前均给予书面知情同意书。研究人员通知参与者,研究结果可能会在学术期刊或书籍上发表。在实验过程中,参与者被告知他们在实验中拥有的权利。在实验过程中,他们可以随时退出。

在研究结束时,所有参与者都获得了将处理后的数据记录公之于众的权限。由于PPB-Emo将向公众开放,因此在公开包含个人身份信息的数据时获得了单独的同意,这些信息是参与者在驾驶任务中的面部表情。额外的权限用于告知他们将公开共享的数据类型,以及共享处理过的数据记录的日期和时间可能导致的重新识别的潜在风险。共享权限由本次研究的所有参与者授予。

实验一:深度访谈,收集司机观点

实验一主要研究驾驶员对诱发人类不同情绪的驾驶场景的看法。

参与者

对27名参与者进行了深入访谈。27例受试者中女性6例(22.22%),男性21例(77.78%)。年龄19 ~ 55岁,平均年龄36.81岁(标准差(SD) = 9.27)。参加者的驾驶经验由1年至25年不等,平均驾驶经验为8.93年(标准差= 6.49)。参与者的职业包括工人、教师、学生、农民、职员、公务员、司机等。

过程

深度访谈的目的是获取诱发人类驾驶员不同情绪的现实场景信息,并将结果用于编制问卷。场景信息收集过程包括与人类司机的半结构化访谈。访谈采用访谈指南法31.所有参与者首先签署人口统计问卷,收集年龄、性别、驾驶经历、职业等个人和人口统计信息。然后,通过对参与者的采访,参与者回答了一组开放式问题(例如,问题“你能分享一个你在开车时感到害怕的经历,甚至当你回忆起来的时候吗?”)。在回答过程中,采访者引导参与者用自己的语言回忆和描述引发不同情绪的驾驶场景,包括道路、天气和光照条件;其他道路使用者的行为;事件;以及其他影响因素(例如,回答“有一次,我晚上在山路上开车,路上一个人也没有。我觉得很困。我的眼睛不由自主地闭上了。当我睁开眼睛时,我发现自己陷入了一个急转弯。 I stepped on the brakes. It made me feel scared.”). Each participant answered seven driving scenarios questions corresponding to different emotions. The interview time for each participant was about 30 minutes and the process was recorded.

收集司机观点的结果

所有深度访谈的录音和现场笔记都被逐字转录,并使用Excel文件进行分析。首先,将27位受访者的原稿分解成完整的句子。接下来,在驾驶员情绪分析方面具有专业知识和丰富经验的两名研究人员(男女各一名)分别对句子进行评估,并在他们的共识下确定陈述中七种情绪对应的主要场景信息。综上所述,诱发人类司机愤怒的场景有11种;有16种场景能让驾驶员产生幸福感;让人类司机害怕的十种场景;11种场景会让人类司机感到恶心;有十种场景会让人类司机感到惊讶;相对而言,触发人类驾驶员悲伤和中性的场景较少,分别为5个和6个。表格2根据参与者的数量,总结了诱发每种情绪的前五种驾驶场景。

实验二:刺激选择在线问卷调查

实验二主要通过问卷调查,获得7个最能有效诱发人类驾驶员相应情绪的驾驶场景,作为视频-音频刺激材料选择的依据。

参与者

409名中国参与者来自四个国家,包括中国、美国、加拿大和新加坡。他们被要求完成一份在线问卷,其中包括146名女性(35.61%)和263名男性(64.39%)。参与者年龄18-71岁,平均年龄31.34岁(SD = 10.64)。参加者的驾驶经验介乎1至41年,平均驾驶经验为5.87年(标准差= 6.69)。

过程

因为在线调查可以避免数据收集的地域限制,而且之前的研究也证实了在线工具在评估驾驶行为方面的有效性32,33.因此,为了收集实验二的数据,我们进行了在线调查。基于实验一的结果,在线问卷分为两部分,共十个问题。第一部分是人口背景。有三个问题,包括性别、年龄和驾驶经验。第二部分以实验一的结果为基础,针对诱发人类驾驶员不同情绪的驾驶场景提出了7个问题。这些问题对应着需要调查的七种情绪。每个问题描述了五种不同的驾驶场景。这些场景描述来自实验一中最常被提及的五个场景,参与者被要求从五个场景中选择最可能引起相应情绪的场景,如果他们愿意,他们可以选择一个以上的场景(最多5个)。完成问卷大约需要10分钟。

专业在线调查平台搜跳(www.sojump.com)设计并发布问卷。自动记录参与者的答案、地区和回答时间。调查分布在社交软件(微信和QQ)的聊天群中。为了提高调查的参与度,参与者在完成调查后将获得5元人民币的奖励。

刺激选择结果

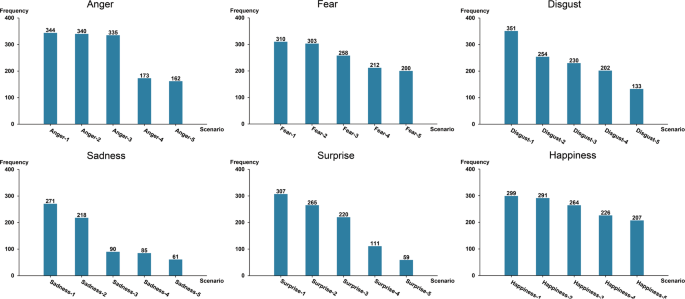

参与者报告了在驾驶过程中容易诱发七种情绪状态(愤怒、恐惧、厌恶、悲伤、惊讶、快乐和中性)的相应场景。表格3.展示409名参与者中容易诱发7种情绪的场景的频率和百分比。其中,共有344人(84.11%)认为“别人开着远光灯接车,影响视力”的场景。最有可能引发他们的愤怒。310名(75.79%)受访者提到“在山道上行驶,路旁有高高的悬崖。”,这会让他们感到恐惧。351名参与者(85.82%)在看到“前面的司机不停地扔垃圾、水瓶、吐痰”的场景时感到恶心。共有271名(66.26%)受访者认为“开车时目睹意外”情景。是最容易让他们伤心的。307名受试者(75.06%)报告“看到一些行人在高速公路上行走”。会让他们大吃一惊。在幸福感方面,299名(73.11%)受访者表示“在路上看到有趣的事情,外面的风景很美”。是最容易让他们开心的。场景对应的频率如图所示。2.此外,273名参与者(66.75%)在边听轻音乐边开车时感觉中立。

容易诱发六种基本情绪的相应场景的频率。x轴表示触发特定情绪的驾驶场景,例如愤怒-1表示其他人在遇到汽车时保持远光灯,这影响了视觉。表格3.描述触发特定情绪的每个场景的内容。y轴表示在线问卷中409个参与者选择场景的频率,每个参与者最多可以选择5个场景。

人类驾驶员的情绪需要通过适当的刺激来诱导来收集情绪数据。视频音频片段已被证明能可靠地触发人类驾驶员的情绪6,34,35.根据问卷调查的结果,我们在Bilibili网站上手动选择了7个最有效的(在每个情感场景中选择参与者比例最高的)视频音频片段(https://www.bilibili.com/)来诱导实验三中人类驾驶员的相应情绪。Bilibili是一个中国的视频分享网站,用户可以上传自己的生活视频,视频观众可以通过一个被称为“弹幕评论”的滚动评论系统对视频进行标记或添加评论,这将帮助我们评估视频观众对视频音频片段的情绪感受。

为了根据在线调查结果选出最有效的视频音频剪辑,两名在司机情绪分析方面经验丰富的研究专家(一男一女)对100多个视频音频剪辑进行了评估。两位专家的共识决定了视频音频剪辑的选择,最终选择了7个视频进行实验三。值得注意的是,为了让驾驶员在实验III中更有身临其境的感觉,并诱导出正确的情绪,实验II中所选择的所有视频音频片段都是人类驾驶员的第一视角。表格4描述这七个剪辑的内容。

实验三:驾驶任务中多模态人类情绪数据采集

实验三的目的是收集驾驶任务中人类情绪的多模态心理、生理和行为数据集。

参与者

本次数据收集实验共招募了41名来自重庆的司机。在这些参与者中,参与者1的数据在收集过程中被发现不完整且无效。原因可能是意料之外的技术问题。因此,本实验共有40位参与者(年龄19-58岁,平均年龄28.10岁,SD = 9.47)的数据有效,其中男性31位,女性9位。所有参与者均持有有效驾照,且至少有1年驾龄(驾龄范围= 1-32年,平均驾龄= 5.58年,SD = 6.02)。所有参与者视力和听力正常/矫正。他们的健康状况在实验开始前被报告。研究人员建议参与者在实验前有规律的24小时作息时间,不服用刺激性药物或酒精。实验结束后,每个参与者获得200元的奖励。

实验设置

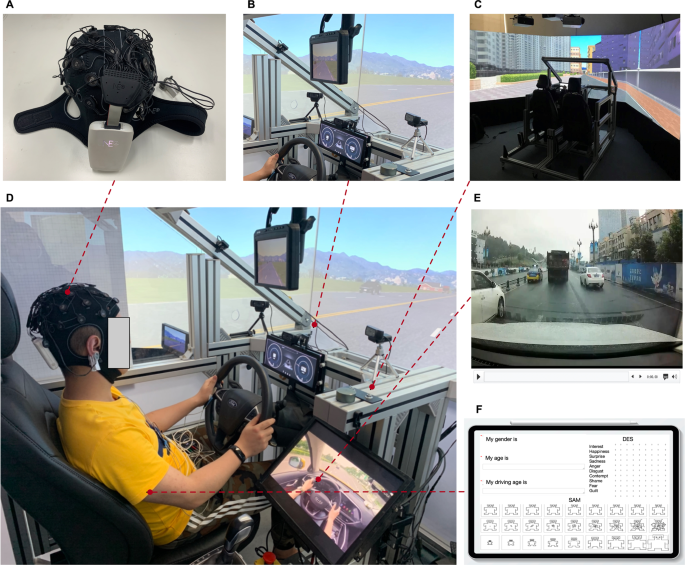

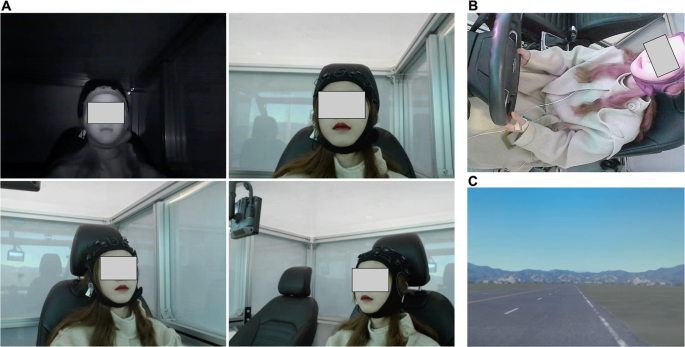

本实验使用的多模态数据采集系统主要包括心理数据采集模块、生理数据采集模块、行为数据采集模块、驾驶员情绪诱导模块、驾驶场景、数据同步。数字3.显示了整个多模态数据采集实验的设置。具体模块内容如下:

人类驾驶员多模态情绪数据采集的实验建立。(一个)脑电图数据采集,(B)视频数据收集,(C)驾驶行为数据收集,(D)实验装置,(E)驾驶员的情绪感应,(F)心理资料收集。图中相关肖像的使用。3.已获得参与者的授权,可识别信息已在参与者知情的情况下匿名化。

心理数据采集模块

本实验采用三种自述量表收集心理数据,包括人体自我评价量表(SAM)、差异情绪量表(DES)、艾森克人格问卷(EPQ)。山姆36用于被试对自己的次元情绪进行主观注释。在SAM中使用非言语图形表征来评估三个维度(唤醒、效价和支配)的水平。实验过程中采用9分制SAM(1 =“完全不”,9 =“极其”)进行评价。DES37用于被试对自己的离散情绪进行主观注释。DES是一种多维度的自我情绪评估量表,包括悲伤、愤怒、蔑视、恐惧、羞耻、兴趣、喜悦、惊讶、厌恶和内疚等十种基本情绪。在实验中,选择9点量表DES(1 =“完全不”,9 =“极其”)作为评估自我报告情绪各维度强度的方法。EPQ38在实验中,共有88个问题被用来评估参与者的性格特征。EPQ是一种多维度的心理测量38,它可以衡量人类的人格特征,包括p -精神/社会化、e -外向/内向、n -神经质/稳定、L-Lie/社会可取性。实验使用iPad(苹果公司,库比蒂诺,美国)来记录参与者在驾驶过程中自我报告的情绪。

生理数据采集模块

实验中使用EnobioNE (Neuroelectrics, Barcelona, Spain)收集参与者的脑电图生理数据。EnobioNE是一种32通道的无线脑电图设备,使用氯丁橡胶帽将通道固定在所需的大脑位置。使用EnobioNE-32系统记录脑电活动。使用干铜电极(涂有银层)固定在帽上,以保证与参与者头皮的良好接触。EnobioNE的振幅分辨率为24 bi (0.05μV),采样率为500hz,带通滤波器在2 ~ 40hz之间。NIC2软件直接捕获信号,该软件包含信号采集和处理程序。在实验过程中,软件同时过滤出眼电信号(EOG)、肌电信号(EMG)和心电图信号。此外,NIC2软件将信道与国际10-10定位系统中的可变位置动态关联。这些位置的alpha波、beta波、gamma波、delta波和theta波通过NIC2软件直接输出到计算机。

在实验前,研究人员建议参与者应该提前洗头,以避免脑电图帽电极接触不良。在参与者正确戴上设备后,检查并调整EnobioNE系统中所有电极的接触状态,直到达到良好的贴合。此外,夹在右耳垂上的共模传感电极被用作地面参考。

行为数据收集模块

行为数据采集模块包括驾驶行为数据采集和视频数据采集。驾驶员行为数据使用固定的驾驶模拟器(Realtime Technologies, Ann Arbor, USA)获得。该模拟器由半驾驶室平台和自动变速器组成,提供270°视野。该模拟器配备了一个模拟投影的后视镜,让司机可以监控后面的交通状况。此外,引擎和环境的声音通过两个扬声器发出。模拟器中的低音扬声器模拟驾驶员座位下车辆的振动。此外,模拟器仪表盘是一个LCD(分辨率1920×720, 60 Hz)屏幕,用于显示速度表,转速表和档位。驾驶员驾驶过程中操作驾驶模拟器产生的驾驶员行为、道路信息、车辆姿态等数据在主控计算机后台实时同步记录。

视频数据采集由6台高清摄像机组成。本实验使用5台RGB摄像机和1台红外摄像机采集驾驶员面部表情、身体手势和道路场景数据。我们使用的RGB相机是Pro Webcam C920 (Logitech, Newark, USA),分辨率为1920×1080像素,以30帧/秒的帧率收集数据。我们使用的红外相机是一台工业级相机,分辨率为1080×720像素,镜头焦距为2.9毫米,拍摄角度为90度无失真。数据收集的帧率为30帧/秒。在驾驶模拟器的座舱内布置了6台摄像机,其中3台RGB摄像机位于受试者面部前方,左右两侧各40°。这些摄像头用于采集面部表情数据,在驾驶模拟器的前柱上设置1台RGB摄像头采集参与者的驾驶姿态数据,在驾驶模拟器的后视镜位置上设置1台RGB摄像头采集驾驶过程中的道路场景信息。红外摄像机被直接放置在参与者的脸前面,也被用来收集面部表情数据。此外,摄像头还用于收集参与者情绪驾驶时的语音信息。使用LiveView软件(EVtech,长沙,中国)同时记录6台高清摄像机的视频信息。

驾驶员情绪感应模块

实验中使用20英寸模拟器中央显示器(分辨率1280×1024, 60 Hz)显示视频-音频刺激材料。使用立体声蓝牙扬声器(小米,中国深圳)播放音频,并将音频设置为较大音量。同时,每个参与者都被问及音量对他们来说是否舒适,以确保在实验前调整了清晰的听力音量。实验三采用实验二中选择的视频音频刺激材料。为了保证实验过程中参与者的情绪诱导不受人为干预,本实验的情绪诱导系统主要由主控机、远程显示器和远程蓝牙音频播放设备组成。

驾驶场景

本实验设计了两个模拟驾驶场景:正式实验场景和模拟驾驶实践场景。练习场景设置旨在通过正式实验前的练习,提高参与者对驾驶模拟器的控制力和熟悉度。练习驾驶的场景是一段8公里长的高速公路,有双向四车道。正式的实验场景是一个总长度为3公里的双向双车道直线路段。设置这两个场景的原因是为了将复杂驾驶条件对驾驶员性能的要求降至最低,最大程度地展现真实的驾驶员情绪所引发的多模态反应39.在整个实验过程中,参与者被要求在正确的车道上行驶,速度保持在80公里/小时左右。两种实验场景的具体配置参数如表所示5.整个驾驶场景使用SimVista和SimCreator软件来构建驾驶场景。

数据同步

为了实现所有数据的同步采集和存储,本实验采用D-lab数据采集同步平台(Ergoneers, Gewerbering, Germany)进行多通道数据采集,包括EEG、驾驶行为数据、视频数据同步记录在一个共同的时间轴上,实现后续的同步分析。此外,还使用D-Lab对实验进行管理和控制。

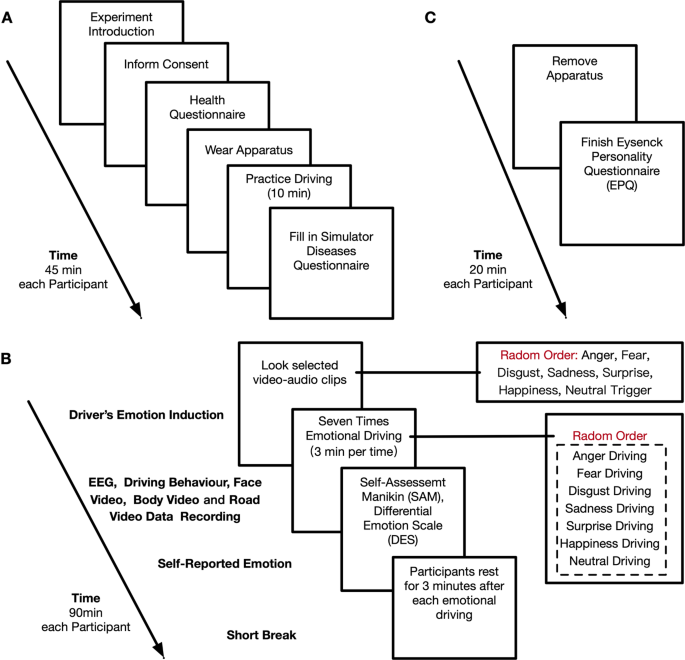

实验过程

整个实验过程分为三个部分:前期准备、情绪驱动实验和实验后访谈。整个过程如图所示。4.

实验准备

- 1.

实验介绍:在参与者到达候诊室后,会向参与者解释本次实验的目的、持续时间以及研究意义。同时告知受试者本实验的数据采集仪器为无创、无辐射仪器,不会对受试者的健康产生任何影响和伤害,并保证受试者的自愿参与。

- 2.

签署参与者知情同意书:指导参与者阅读《参与者知情同意书》,研究人员将为参与者编号并登记基本信息。

- 3.

完成实验参与者的健康状况表:检查参与者在日常生活中的健康状况,以及在过去12小时内是否服用过精神类药物、感冒过敏药物或酒精。研究人员将评估参与者的情况,看他们是否适合参加实验。

- 4.

佩戴测试仪器:研究人员帮助被试佩戴EEG。戴上脑电图帽后,研究人员会调整舒适度,观察电极是否贴合,信号采集是否正常。

- 5.

模拟器练习驾驶:研究人员将带领参与者坐在驾驶舱内,并将座椅的位置调整到合适的位置。然后,研究人员会帮助参与者适应驾驶模拟器的速度控制,并提醒参与者根据速度标志驾驶。在练习驾驶的过程中,研究人员会站在副驾驶的位置向参与者讲解正式的实验流程、步骤和注意事项。

- 6.

填写驾驶模拟器疾病问卷:检查参与者在驾驶模拟器实验过程中是否有身体不适。

多模态人类情感数据采集

在正式实验中,参与者被要求在愤怒、悲伤、恐惧、厌恶、惊讶、快乐和中性七种情绪状态下完成驾驶任务,其中情绪诱导的顺序是随机选择的。每次实验结束后,都设置3分钟的情绪冷静期,让参与者从上一段情绪中冷静下来。

- 1.

情绪诱导:研究者将预设的驾驶场景程序加载到驾驶模拟器中,同时随机播放视频音频片段给被试进行情绪诱导。参与者观看视频音频刺激材料,并试图在驾驶时保持他们的情绪。

- 2.

情绪驾驶:被试观看完情绪诱导材料后,在D (driving)档开始情绪驾驶,实验平台同时开始记录数据。参与者被要求在情绪驾驶阶段将速度保持在80公里/小时左右。

- 3.

情绪自我报告:在完成一段时间的情绪驾驶后,参与者被要求通过完成SAM量表和DES量表的自我评估问卷来回忆他们在驾驶场景中的情绪状态。

- 4.

重复以上两步,直到参与者完成七次情绪驾驶。在参与者完成相应的SAM量表和DES量表后,研究者将记录实验过程。

创意人恭谨有加面试

在完成所有情绪驱动实验后,研究者会帮助被试取下实验仪器,然后引导被试完成EPQ问卷。

数据记录

数据总结

本节讨论了Figshare中PPB-Emo数据集的组织40.表格6总结了PPB-Emo数据集的数据采集。在采集完上述数据后,每位参与者完成了7次模拟器驾驶和数据记录。因此,40名参与者共完成280次驾驶,每次驾驶时间约为135 s。为了验证被试在特定驾驶场景下是否体验到目标情绪,我们进行了目标情绪诱导成功检验。

以每个参与者的DES作为ground truth来验证目标情绪是否由参与者在情绪驾驶过程中产生。当自我报告的情绪与目标情绪不一致时,选择自我报告的情绪作为基础事实。结果表明,在愤怒、悲伤、恐惧、厌恶、惊讶、快乐和中性驾驶这4种情绪驾驶中,分别有34人、38人、36人、25人、34人、36人、37人成功诱导进入目标情绪。同时,我们删除了每一组未成功诱导的数据。

由此产生的PPB-Emo数据集包含240组来自40名参与者的有效多模态数据,总计540分钟的原始数据。它包括40名参与者在驾驶任务中的心理数据、生理数据和行为数据。表格7总结了PPB-Emo数据集的详细信息。

数据集内容

参与者级别的信息经过预处理,以按照通用数据保护条例(GDPR)完成去身份化41.对于跨数据的时间同步,我们将所有时间戳从UTC + 8转换为UTC + 0并剪切原始数据。以往的研究表明,人类情绪的生理表达至少可以持续30秒15,42.因此,基于驾驶行为数据的换档信息,我们认为参与者开始驾驶30 s后的多模态数据是数据处理中最有效的数据。

对于每个参与者的EEG数据和驾驶行为数据,我们首先从D-Lab导出原始数据,数据格式为。txt。然后我们将数据格式转换为。csv,并将前30秒的驾驶行为数据和EEG数据作为最有效的数据进行剪切,分别重命名并存储。对于每个参与者的视频数据,我们首先从Liveview导出原始视频数据,数据格式为。mp4。随后,我们将前30秒的视频数据进行剪辑,作为最有效的数据,将原始拍摄分成6张图像,分别存储和重命名,包括道路场景视频、红外中间人脸视频、驾驶身体手势视频、RGB左人脸视频、RGB中人脸视频、RGB右人脸视频。请注意,任何未经编辑的视频和原始日志级别的数据录音将不会被提供。同时,这些数据的预处理代码也不会公开,因为其中包含的隐私敏感信息超出了我们允许共享的信息的边界。更多细节可以在代码可用性部分找到。

在数据集的根路径中,它被组织成以下七个主要目录:心理数据、生理数据、驾驶行为数据、面部表情数据、身体手势数据、道路场景数据和脚本。这些目录中的README.TXT文件将给出详细的解释。为每个参与者分配一个唯一的两位数参与者ID。

Psychological_data

该目录包含参与者传记、自我报告情绪标签和人格特质的数据,共3个.xlsx文件。

BIO.XLSX.每一行包含参与者的传记数据,按参与者ID、性别(1 =男性,2 =女性)、年龄和驾驶年龄组织。

情感label.XLSX.每一行都包含参与者所经历的情绪的自我报告数据,根据参与者ID、效价、唤醒、主导地位、类别和强度进行组织。SAM量表用于测量效价、唤醒和支配,DES量表用于测量类别和强度。表中显示了每行内容的组织结构10.

EPQ.XLSX.每行包含参与者的艾森克人格问卷数据,按照参与者ID、P-score、E-score、N-score、L-score进行整理,其中P reï,代表精神病性/社会化,E代表外向性/内向性,N代表神经质/稳定性,L代表谎言/社会可取性。

Physiological_data

在这个目录下又划分了40个子文件夹,每个子文件夹包含了每个被试的所有脑电信号的数据。这些子文件夹以参与者ID命名,包含多个CSV文件。每个CSV文件都对应有效的情绪驱动。每行包含瞬时测量的脑电图数据,按照rectime, UTC, 32通道脑电图数据,α β γ δ θ每个信道的频带数据。表中显示了每行内容的组织结构8.此外,该目录中还包含EEG蒙太奇描述文件。TXT文件描述了为显示整个头部活动而创建的通道信息,并提供侧化和局部化信息,这将有助于理解和分析脑电图数据。

Driving_behavioural_data

该目录下进一步划分了40个子文件夹,每个子文件夹包含了一个参与者的所有驾驶行为数据(DBD)。这些子文件夹以参与者ID命名,包含多个CSV文件。每个CSV文件都对应有效的情绪驱动。每一行包含瞬时测量的驾驶行为数据,并根据rectime、UTC、加速度、横向加速度、油门踏板位置、制动踏板力、齿轮、方向盘位置、速度、横向速度、x位置、y位置、z位置进行组织。表中显示了每行内容的组织结构9.

Facial_expression_data

在这个目录下又划分了40个子文件夹,每个子文件夹包含了每个参与者所有的面部表情数据。子文件夹以参与者ID命名,包括4个子文件夹,分别是中央RGB (CRGB)面部表情数据、左RGB (LRGB)面部表情数据、右RGB (RRGB)面部表情数据和中央红外(CIR)面部表情数据。每个文件夹包含多个MP4文件,每个MP4文件对应有效的情绪驱动。参与者情绪驾驶记录的面部表情数据如图所示。5.

PPB-Emo数据集视频数据内容。(一个)面部表情数据,包括中央红外面部表情、中央RGB面部表情、左RGB面部表情、右RGB面部表情;(B)身体手势数据,(C)道路情景数据。图中相关肖像的使用。5已获得参与者的授权,可识别信息已在参与者知情的情况下匿名化。

Body_gesture_data

在这个目录下又划分了40个子文件夹,每个子文件夹都包含了每个参与者的身体手势数据。这些子文件夹以参与者ID命名,包括多个MP4文件。每个MP4文件对应有效的情绪驱动。参与者情绪驾驶记录的身体手势数据如图所示。5.

Road_scenario_data

该目录分为40个子文件夹,每个文件夹包含每个参与者驾驶道路场景的数据。这些子文件夹以参与者ID命名,包括多个MP4文件。每个MP4文件对应有效的情绪驱动。参与者情绪驾驶记录的驾驶道路场景数据如图所示。5.

Selected_stimulus_clips

该目录包含一个选定的视频音频剪辑的子文件夹和一个剪辑原始links.xlsx文件。

精选视频音频片段.此子文件夹包含七个选定的视频音频剪辑,用于驾驶员情绪诱导。七个片段对应的目标情绪是愤怒、悲伤、厌恶、恐惧、快乐、中性和惊讶。

选择视频音频剪辑原始链接。xlsx.每行包含选定的目标情绪的视频音频剪辑原始链接,按目标情绪和原始链接进行组织。

脚本

预处理和主要分析代码(Python脚本)在此目录中进行了总结。技术验证部分中的所有结果都可以使用这些脚本复制。要了解更多细节,请阅读README中的说明。md文件。

技术验证

我们的验证包括情绪标签的可靠性验证,生理和行为数据的质量验证,以及生理、行为和情绪标签的相关性分析。

情绪标签的信度验证

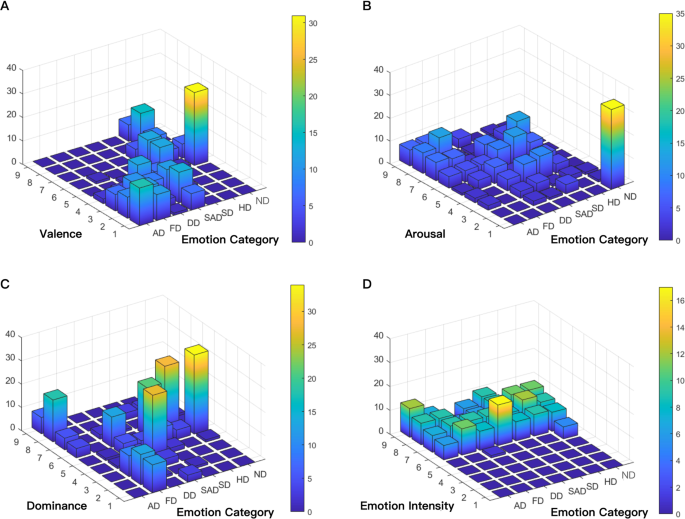

本节介绍一种k均值聚类算法43为40名参与者的主观评分分数的分布提供直观的可视化分析。然后利用三维直方图对各情绪标签的分布进行总结。

情感标签的聚类与可视化分析

我们使用的SAM从三个维度评估情绪:效价、觉醒和支配。为了验证可靠性,我们对这三个维度进行了数据聚类和可视化分析。为了保证每个特征都得到平等对待,我们使用最大-最小归一化方法将所有主观分数投影到0到1的范围,从而对数据进行了无量纲化。然后,以效价、唤醒和支配为散点图的坐标值。数字6(一)显示归一化后40名参与者评分得分的分布。

使用k均值算法对评分进行聚类,每个聚类的中心如图所示。6(一).7个聚类分别代表7种离散的情绪,包括愤怒驾驶、恐惧驾驶、厌恶驾驶、悲伤驾驶、意外驾驶、快乐驾驶和中性驾驶。各聚类中心点无重叠,聚类分类较为明显,尤其是快乐驾驶、愤怒驾驶和恐惧驾驶场景。由于情绪的复杂性,以及参与者在打分时对某些情绪的不同理解,其他聚类点部分重叠。为了提供更全面的显示,我们将3-D散点图投影到2-D图。数字6(罪犯)显示投影后的结果,每个聚类的中心点仍然没有重叠,聚类的分类比较明显。

情绪标签的分布分析

被试在效价、唤醒和支配、情绪类别和强度方面的评分得分见图。7.横坐标表示七个情绪类别,纵坐标表示主观得分的数值,z坐标表示每个项目的总数。

数字7(一)表示价电子的分布。根据定义,效价是指一种情绪的积极或消极。积极情绪的效价得分较高,而消极情绪的效价得分较低。数据分布如图1所示。7(一)符合这个模式。消极情绪(如悲伤、愤怒、厌恶、恐惧)的效价分值主要分布在1 ~ 4之间,而积极或中性情绪(如中性、高兴、惊讶)的效价分值主要分布在5 ~ 9之间。通过符合正态分布模式,验证了效价得分。

数字7 (B)显示了觉醒的分布。根据定义,觉醒的范围从兴奋到放松。数据分布如图1所示。7 (B)遵循这个模式。无花果。7 (B)由图可知,中性的唤醒得分仅位于1,表示被试此时感到放松,没有积极或消极的情绪。该特征符合我们的客观经验,验证了唤醒数据的可靠性。

数字7 (C)显示了优势的分布。根据价价-觉醒-支配模型,支配的范围从服从到支配。恐惧是低支配地位,愤怒是高支配地位。恐惧驱动的分布如图所示。7 (C)主要集中在1和3之间,符合这个模式。其他情绪的分布主要集中在4 - 6之间,说明被试对这些情绪的控制处于中等水平。通过符合正态分布模式,验证了优势度评分的可靠性。

数字7 (D)显示了情绪强度的分布。根据DES的定义,不同情绪强度与强度的得分呈正相关。由于所有的数据都分布在5到9之间,而且大多数分布在6到9之间,因此该分布验证了参与者的情绪已被成功刺激。

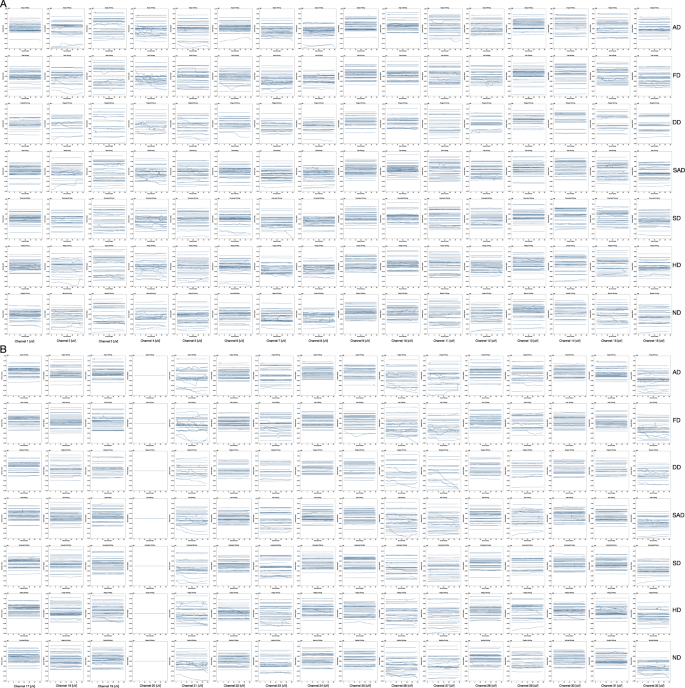

生理和行为数据的质量验证

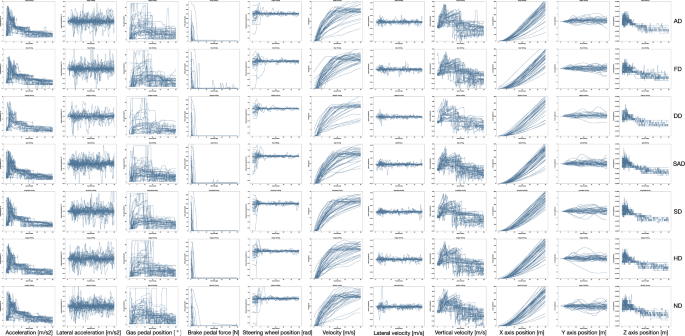

对于研究中涉及的每个变量,我们都进行了可视化显示和质量控制,并且对数据测量的质量进行了彻底的测试。以时间函数的形式提取相关信号。经过质量控制后,每个驱动器的总体结果如图所示。8而且9.

生理数据

我们用来获取脑电图信号的设备是一个头戴式设备。数据是通过电极获得的。因此,参与者头发的数量和长度会影响电极的接触和结果。因此,良好的联系是获得有效数据的必要条件。提取有效数据,如图所示。8,其中包含了不同情绪状态下32通道EEG信号的趋势曲线。从图中我们可以看出。8,除20号信道外,大多数信道采集的信号具有明显的相似性和趋势。由于实验过程中接触不良,20通道信号无效。

驾驶行为数据

这些变量包括代表驾驶行为的11个动力学参数,包括加速度、油门/刹车踏板的程度/力、速度和位置,这些参数提供了对驾驶行为的全面描述。数字9展示了7种不同情绪下不同驾驶行为的时间函数。图中的每个子图。9包含40条曲线,每条曲线表示参与者驾驶信号的时间函数。所有的驾驶行为数据都是通过上面提到的驾驶模拟器获得的。如图所示。9,驾驶行为数据在同一情绪上的倾向是一致的。

生理、行为和情绪标签的相关性分析

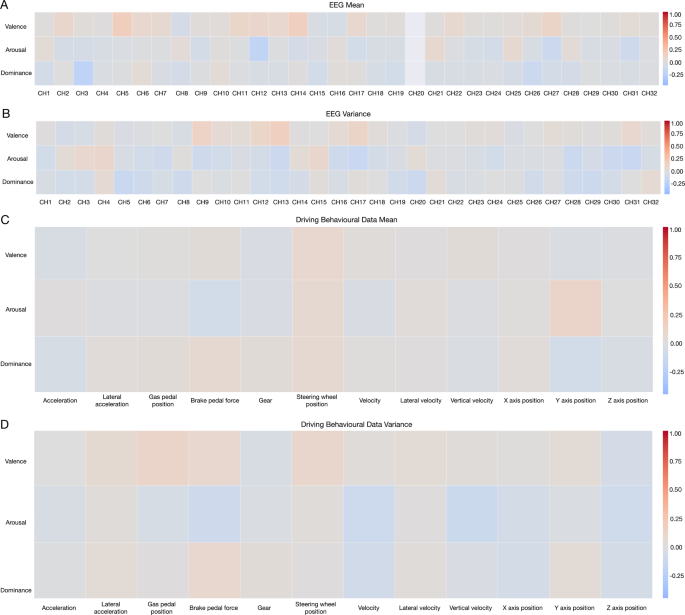

数字10示Spearman相关分析44在11种驾驶行为中,32通道脑电图信号和3个维度的情绪。相关性以热图的形式显示出来。在无花果。10时,首先使用最大-最小归一化方法对数据进行无量纲化。然后,分别计算每个参与者的数据的均值和方差值,并将处理后的数据与情绪得分的3个维度结合在一起。然后采用Spearman相关分析得到相关系数。相关系数取值范围为−1 ~ 1。

生理数据和情感标签

无花果。10 ()为脑电图信号均值与情绪三维得分的相关热图。价价通道(CH)5/CH11/CH14/CH27组、觉醒- ch12 /CH27/CH31组和显性- ch3 /CH26组相关性显著。数字10 (B)为脑电信号方差值与情绪三维得分的相关热图。价性-CH9/CH12/CH13/CH17组、觉醒性- ch4 /CH7/CH9/CH13/CH16/CH17/CH28/CH30/CH31组与显性- ch5 /CH6/CH8/CH20 /CH28/CH29组相关性显著。

行为数据和情感标签

无花果。10 (C)为驾驶行为数据均值与情绪三维得分的相关热图。对相关系数进行归一化处理。觉醒-制动踏板力组间存在高度显著性相关性。数字10 (D)为驾驶行为数据方差值与情绪三维得分的相关热图。价格-油门踏板度、唤醒-刹车踏板力、唤醒-垂直速度/速度、优势-速度组之间存在极显著相关性。

使用笔记

用户可以使用任何视频播放工具(如QuickTime Player)打开。mp4文件。用户可以使用任何电子表格或工作簿软件打开。csv文件。数据可以直接导入Python、Matlab等统计或编程工具进行分析。我们建议用户检查数据库中的示例报告以进一步澄清。

潜在的应用

在各种数据挖掘技术的帮助下,该数据集可用于分析人类驾驶员的情绪-生理-行为-性格特征之间的关系45,46.它可以用来分析人类驾驶员的情绪引起的驾驶风险13,47.它还可以用来分析驾驶场景和生活场景中人类情感表达的差异6,48.该数据集还可用于分析人类驾驶员在驾驶环境中不同情绪下的认知和行为变化,进而对人类驾驶员的情绪调节策略进行研究46,49.

此外,通过应用各种机器学习技术,基于收集到的驾驶行为、脑电图、面部表情、驾驶姿势和道路场景信息,该数据集可用于开发单模态/多模态驾驶员情绪监测算法35,50.准确高效的情绪监测算法将有助于人类驾驶员与智能车辆之间的情感感知交互,提高驾驶安全性和舒适性,增加人类对机器的信任46,51.此外,PPB-Emo数据集也将有利于其他日常任务中的人类情感研究。

局限性和未来工作

驾驶员情绪诱导。这项研究使用视频音频剪辑来诱导司机的情绪。虽然所有这些视频音频片段都已被验证能够有效地激发预期的人类驾驶员情绪,但本研究不能完全排除视频音频片段诱导的情绪与真实道路驾驶场景诱导的情绪存在差异的可能性。未来,我们将进一步开展道路驾驶实验,研究人类驾驶员在真实道路驾驶场景下的情绪。

参与者。在本研究的三个实验中都存在性别失衡,男女比例为3:1。尽管这与中国司机的男女比例基本相同52,这可能会影响数据集的使用。未来的研究应该尽可能地保持性别比例的平衡。此外,在实验二中,409名中国参与者被邀请在线回答问卷。因为引发相同情绪的场景在不同的文化中可能有所不同53实验二提供的驾驶场景对不同文化群体的诱导效果有待进一步研究。

代码的可用性

技术验证部分中提到的数据预处理方法和验证程序在Jupyter Notebook中进行。Python版本3.5.8贯穿始终。利用seaborn、sciki-learn进行相关分析和分布显示54还有熊猫包。代码和简要说明(readme.md)已上传。

参考文献

Williams, S. E., Lenze, E. J. & Waring, J. D.只有当情绪与任务相关时,积极信息才会促进老年人的反应抑制。认知与情感34, 1632 - 1645,https://doi.org/10.1080/02699931.2020.1793303(2020)。

情绪和动机如何指导执行控制?认知科学的发展趋势13, 160 - 166,https://doi.org/10.1016/j.tics.2009.01.006(2009)。

真恶心,J。J。情绪调节手册(吉尔福德出版社,纽约市,2013年)。

Hoemann, K. & Feldman Barrett, L.在情感和认知的研究中,概念消解了人为的界限,统一了身体、大脑和思想。认知与情感33, 67 - 76,https://doi.org/10.1080/02699931.2018.1535428(2019)。

柯柏走,S。等.老年司机在自然道路驾驶任务中的驾驶模式与他们之前四个月的真实驾驶模式的比较。安全科学125, 104652,https://doi.org/10.1016/j.ssci.2020.104652(2020)。

李,W。等.智能车辆自发驾驶员情绪面部表情(防御)数据集:驾驶场景中由视频音频剪辑触发的情绪。IEEE情感计算汇刊01 - 1,https://doi.org/10.1109/TAFFC.2021.3063387(2021)。

AAA.新的美国驾驶调查:2019年7月至2020年6月更新的方法和结果。打印https://newsroom.aaa.com/wp-content/uploads/2021/07/New-American-Driving-Survey-Fact-Sheet-FINAL.pdf(2020)。

MTPRC。中国汽车保有量达到3.8亿辆。打印http://www.caam.org.cn/chn/11/cate_76/con_5233729.html(2021)。

丁格斯,t.a.。等.基于自然驾驶数据的驾驶员碰撞风险因素及流行度评估。美国国家科学院院刊113, 2636 - 2641,https://doi.org/10.1073/pnas.1513271113(2016)。

威肯斯,c.m.,曼恩,r.e, ialomitanu, a.r. &斯托杜托,G.司机的愤怒和攻击性会导致撞车吗?人口水平的分析。交通研究F部分:交通心理与行为42, 389 - 399,https://doi.org/10.1016/j.trf.2016.03.003(2016)。

埃里森-波特,P.,贝尔,P. & Deffenbacher, J.特质驱动愤怒,匿名,和攻击性刺激对攻击性驾驶行为的影响。应用社会心理学杂志31, 431 - 443,https://doi.org/10.1111/j.1559-1816.2001.tb00204.x(2001)。

Mesken, J., Hagenzieker, M. P., Rothengatter, T. & De Waard, D.不同司机情绪的频率、决定因素和后果:一项使用自我报告、(观察到的)行为和生理的道路研究。交通研究F部分:交通心理与行为10, 458 - 475,https://doi.org/10.1016/j.trf.2007.05.001(2007)。

斯蒂芬斯,A. N. &格罗格,J. A.愤怒一致行为在驾驶情况下转移。认知与情感25, 1423 - 1438,https://doi.org/10.1080/02699931.2010.551184(2011)。

邓,Z。等.基于驾驶风格识别的驾驶员转向行为的概率模型。IEEE系统、人与控制论汇刊:系统52, 1838 - 1851,https://doi.org/10.1109/TSMC.2020.3037229(2020)。

李,W。等.基于视觉属性的愤怒驾驶行为情绪调节。IEEE智能交通系统杂志1428,https://doi.org/10.1109/MITS.2021.3050890(2021)。

比格曼,Y. E. &格雷,K.自动驾驶汽车的生死决定。自然579E1-E2,https://doi.org/10.1038/s41586-020-1987-4(2020)。

Amolika, S., Sai, C., Vincent, V., Huang, C. & Vinayak, D.加州公共道路上自动驾驶车辆的碰撞和脱离数据。科学数据8, 0 - 0,https://doi.org/10.1038/s41597-021-01083-7(2021)。

Zepf, S., Hernandez, J., Schmitt, A., Minker, W. & Picard, R. W.智能车辆驾驶员情感识别:一项调查。ACM计算调查53行,https://doi.org/10.1145/3388790(2020)。

Olaverri-Monreal, C.促进对自动驾驶汽车的信任。电子性质3., 292 - 294,https://doi.org/10.1038/s41928-020-0434-8(2020)。

努涅斯,A.,雷默,B.和考夫林,J. F.人们必须保持对自动驾驶汽车的控制。打印//www.scienovate.com/articles/d41586-018-04158-5(2018)。

McDuff, D. & Czerwinski, M.设计情感感知代理。ACM通信61, 74 - 83,https://doi.org/10.1145/3186591(2018)。

ERTRAC。互联自动驾驶路线图。打印https://www.ertrac.org/uploads/documentsearch/id57/ERTRAC-CAD-Roadmap-2019.pdf(2019)。

ISO / tr - 21959 - 1。道路车辆。自动驾驶环境中的人的性能和状态。第1部分:共同的基本概念打印https://www.iso.org/standard/78088.html(2020)。

李。等.驾驶员对车载愤怒干预系统的态度、偏好和接受程度及其与人口统计学和性格特征的关系。国际工业工效学杂志75, 102899,https://doi.org/10.1016/j.ergon.2019.102899(2020)。

Berdoulat, E, Vavassori, D. &萨斯特,M. T. M.驾驶愤怒,情绪和工具性攻击性,以及攻击性和越界驾驶预测中的冲动性。事故分析与预防50, 758 - 767,https://doi.org/10.1016/j.aap.2012.06.029(2013)。

▽全m:开车时不要哭=悲伤的驾驶和愤怒的驾驶一样糟糕。国际人机交互杂志32, 777 - 790,https://doi.org/10.1080/10447318.2016.1198524(2016)。

凯尔特纳,D., Sauter, D., Tracy, J. & Cowen, A.情绪表达:基本情绪理论的进展。非语言行为杂志28,https://doi.org/10.1007/s10919-019-00293-3(2019)。

李,b.g.。等.驾驶者可穿戴移动情绪反应监测系统。IEEE人机系统汇刊47, 636 - 649,https://doi.org/10.1109/THMS.2017.2658442(2017)。

Braun, M., Weber, F. & Alt, F.情感汽车用户界面-回顾驾驶员情感研究和情感调节在汽车中的状态。ACM计算调查541-26,https://doi.org/10.1145/3460938(2021)。

曾铮,潘蒂克,黄铁生,罗士曼,郭毅和,情感识别方法综述:音频、视觉和自发表达。模式分析和机器智能的IEEE汇刊3139-58,https://doi.org/10.1109/TPAMI.2008.52(2009)。

巴顿,m.q.定性研究与评价方法:理论与实践相结合(Sage出版社,千橡,2014)。

张,T。等.初始信任和感知风险在公众接受自动驾驶汽车中的作用。交通运输研究C部分:新兴技术98, 207 - 220,https://doi.org/10.1016/j.trc.2018.11.018(2019)。

张涛,陈爱华,李生,张伟,曲欣。中国司机的驾驶愤怒及其与攻击性驾驶的关系。交通研究F部分:交通心理与行为56, 496 - 507,https://doi.org/10.1016/j.trf.2018.05.011(2018)。

Roidl, E., Siebert, f.w., Oehl, M. & Höger, R.介绍了一个预测驾驶表现的多元模型:驾驶愤怒和个人特征的作用。安全研究杂志4747-56,https://doi.org/10.1016/j.jsr.2013.08.002(2013)。

李,W。等.Cogemonet:一种用于智能座舱的认知特征增强驾驶员情绪识别模型。IEEE计算社会系统汇刊9, 667 - 678,https://doi.org/10.1109/TCSS.2021.3127935(2021)。

情绪测量:自我评价模型与语义差异。行为治疗和实验精神病学杂志2549-59,https://doi.org/10.1016/0005 - 7916 (94) 90063 - 9(1994)。

葛罗斯,J. J. &利文森,R. W.用电影激发情感。认知与情感9, 87 - 108,https://doi.org/10.1080/02699939508408966(1995)。

艾森克,H. J. & S. B. G.;艾森克人格问卷手册(青少年及成人)(霍德和斯托顿教育,伦敦,1975)。

Taamneh, S。等.一个多模态数据集的各种形式的分心驾驶。科学数据4, 1-21(2017)。

Li, W. PPB-Emo:驾驶任务中人类情绪的多模态心理、生理和行为数据集,figshare,https://doi.org/10.6084/m9.figshare.c.5744171.v1(2022)。

欧盟。通用数据保护条例(gdpr)。打印https://gdpr.eu/tag/gdpr/(2019)。

李文森,R. W., Carstensen, L. L., Friesen, W. V. & Ekman, P.老年的情绪、生理和表达。心理学与衰老628岁https://doi.org/10.1037/0882-7974.6.1.28(1991)。

李佳杰,李佳杰,李佳杰。基于全局k-均值聚类算法的研究。模式识别36, 451 - 461,https://doi.org/10.1016/s0031 - 3203 (02) 00060 - 2(2003)。

史矛曼秩相关系数的显著性检验。美国统计协会杂志67, 578 - 580,https://doi.org/10.1080/01621459.1972.10481251(1972)。

费尔克拉夫,S. H.和多宾斯,C.通勤驾驶期间的个人信息学和负面情绪:数据可视化对心血管反应和情绪的影响。国际人机研究杂志144, 102499,https://doi.org/10.1016/j.ijhcs.2020.102499(2020)。

内,K。等.情绪识别能力与智力关系的元分析。认知与情感34, 329 - 351,https://doi.org/10.1080/02699931.2019.1632801(2020)。

Šeibokaitė, L., endriulaitien, A., Sullman, M. J., markaviitt, R. & Žardeckaitė-Matulaitienė, K.立陶宛司机的情绪调节困难和风险驾驶。预防交通伤害18, 688 - 693,https://doi.org/10.1080/15389588.2017.1315109(2017)。

松本,D. & Ekman, P.美日文化差异的情绪表情强度评级。动机和情绪13, 143 - 157,https://doi.org/10.1007/BF00992959(1989)。

萨尼,S. R. H.,塔比比,Z.,法达尔迪,J. S. &斯塔夫里诺斯,D.攻击性、情绪自我调节、注意力偏差和认知抑制预测危险驾驶行为。事故分析与预防109, 78 - 88,https://doi.org/10.1016/j.aap.2017.10.006(2017)。

兰,Z.,苏丽娜,O.,王,L., Scherer, R. & Müller-Putz, G. R.基于脑的情绪识别域自适应技术:两个公共数据集的比较研究。认知与发展系统汇刊11, 85 - 94,https://doi.org/10.1109/TCDS.2018.2826840(2018)。

Yokoi, R. & Nakayachi, K.对自动驾驶汽车的信任:探索共同的道德价值观、推理和情感在安全关键决策中的作用。人为因素63, 1465 - 1484,https://doi.org/10.1177/0018720820933041(2020)。

中国汽车工业协会。全国机动车保有量超过3.95亿辆。打印http://www.caam.org.cn/chn/11/cate_120/con_5235344.html(2022)。

松本,D. & Hwang, H. S.文化与情感:生物和文化贡献的整合。跨文化心理学杂志43, 91-118(2012)。

Pedregosa F。等.Scikit-learn: python中的机器学习。机器学习研究杂志12, 2825 - 2830,https://doi.org/10.5555/1953048.2078195(2011)。

Ma, Z., Mahmoud, M., Robinson, P., Dias, E. & Skrypchuk, L.驾驶员复杂心理状态的自动检测。在计算科学及其应用国际会议, 678 - 691,https://doi.org/10.1007/978-3-319-62398-6_48(施普林格,Cham, 2017)。

Angkititrakul, P., Petracca, M., Sathyanarayana, A. & Hansen, J. H. Utdrive:车内环境的驾驶员行为和语音交互系统。在智能汽车研讨会, 566 - 569,https://doi.org/10.1109/IVS.2007.4290175(IEEE,纽约,2007)。

希利,J. A.和皮卡德,R. W.在实际驾驶任务中使用生理传感器检测压力。IEEE智能交通系统汇刊6, 156 - 166,https://doi.org/10.1109/TITS.2005.848368(2005)。

确认

国家重点研究发展计划项目(批准号:2019YFB1706102)和国家自然科学基金重大项目(批准号:52131201)资助了本研究。作者感谢肖华飞,刘玉静,薛继勇,钟英浩,林颖,李成某,张俊成,陈浩的数据收集。

作者信息

作者及隶属关系

贡献

W.L.设计、准备、进行实验I/II/III的数据收集,进行数据整理分析,撰写和编辑稿件。R.T.进行了技术验证,撰写并编辑了手稿。Y.X.对数据分析方法做出了贡献,并编辑了手稿。G.L.参与设计了实验III并编辑了手稿。S.L.对手稿进行了编辑和修改。G.Z.执行数据管理和处理。P.W.准备并进行了实验三的数据收集。实验三的数据采集工作由B.Z.负责准备和完成。X.S.负责实验I/II的数据收集。D.P.建议、修改并审阅了手稿。 G.G. supervised the experiment, provided the resources, and reviewed the manuscript. D.C. supervised the experiment, advised, revised, and reviewed the manuscript. All authors have read and agreed to this version of the manuscript.

相应的作者

道德声明

相互竞争的利益

作者声明没有利益竞争。

额外的信息

出版商的注意施普林格自然对出版的地图和机构从属关系中的管辖权主张保持中立。

权利和权限

开放获取本文遵循知识共享署名4.0国际许可协议(Creative Commons Attribution 4.0 International License),允许以任何媒介或格式使用、分享、改编、分发和复制,只要您对原作者和来源给予适当的署名,提供知识共享许可协议的链接,并注明是否有更改。本文中的图像或其他第三方材料包含在文章的创作共用许可中,除非在材料的信用额度中另有说明。如果内容未包含在文章的创作共用许可协议中,并且您的预期使用不被法定法规所允许或超出了允许的使用范围,您将需要直接获得版权所有者的许可。要查看此许可证的副本,请访问http://creativecommons.org/licenses/by/4.0/.

关于本文

引用本文

李,W,谭,R,邢,Y。et al。驾驶任务中人类情绪的多模态心理、生理和行为数据集。科学数据9, 481(2022)。https://doi.org/10.1038/s41597-022-01557-2

收到了:

接受:

发表:

DOI:https://doi.org/10.1038/s41597-022-01557-2