摘要gydF4y2Ba

分子图表示学习在分子分析和药物发现方面显示出相当大的优势。由于难以获得分子属性标签,基于自监督学习的预训练模型在分子表征学习中越来越受欢迎。值得注意的是,在大多数现有的工作中,图神经网络(GNN)被用作编码分子隐式表示的骨干。然而,vanilla GNN编码器忽略了分子基序中隐含的化学结构信息和功能,并且通过READOUT函数获得图级表示阻碍了图和节点表示的交互。在本文中,我们提出了层次分子图自监督学习(HiMol),它引入了一个预训练框架来学习分子表示以进行性质预测。首先,我们提出了一个分层分子图神经网络(HMGNN),它编码基序结构并提取节点-基序-图的分层分子表示。然后,引入多级自监督预训练(Multi-level Self-supervised Pre-training, MSP),将相应的多级生成和预测任务设计为HiMol模型的自监督信号。最后,在分类和回归任务中优越的分子性质预测结果证明了HiMol的有效性。此外,下游数据集的可视化性能表明,HiMol学习的分子表示可以捕获化学语义信息和性质。gydF4y2Ba

简介gydF4y2Ba

近年来,分子表示学习在化学药物分析和发现研究中越来越受到重视gydF4y2Ba1gydF4y2Ba.受到机器学习的巨大成功的激励gydF4y2Ba2gydF4y2Ba,尤其是深度学习gydF4y2Ba3.gydF4y2Ba近年来,分子表示学习越来越多地探索基于机器学习的方法。这些方法被广泛应用于各种分子应用,如化学性质预测gydF4y2Ba4gydF4y2Ba,gydF4y2Ba5gydF4y2Ba,药物分子生成gydF4y2Ba6gydF4y2Ba,gydF4y2Ba7gydF4y2Ba,gydF4y2Ba8gydF4y2Ba,和优化gydF4y2Ba9gydF4y2Ba.如何学习全面有效的分子表示仍然是一个开放的挑战。gydF4y2Ba

受自然语言处理(NLP)发展的启发gydF4y2Ba10gydF4y2Ba,gydF4y2Ba11gydF4y2Ba,gydF4y2Ba12gydF4y2Ba在美国,有一系列方法应用语言模型来处理基于字符串的分子表示,如SMILESgydF4y2Ba13gydF4y2Ba和SELFIESgydF4y2Ba14gydF4y2Ba.具体来说,这些分子串由循环神经网络编码(如门控循环单元(GRU))gydF4y2Ba15gydF4y2Ba长短期记忆(LSTM)gydF4y2Ba16gydF4y2Ba或变压器gydF4y2Ba12gydF4y2Ba,可以通过预测分子性质以监督的方式进行训练gydF4y2Ba17gydF4y2Ba.此外,为了处理大量未标记的数据,许多工作都关注自监督学习(SSL)框架。SSL解码器通常生成原始字符串gydF4y2Ba18gydF4y2Ba或其他输入分子的随机微笑gydF4y2Ba19gydF4y2Ba或者恢复分子串的掩码符号gydF4y2Ba20.gydF4y2Ba.由于弦的单维,分子图的重要拓扑结构被忽略了。因此,许多研究人员已经将他们的兴趣从一维分子串转变为二维图形gydF4y2Ba21gydF4y2Ba,gydF4y2Ba22gydF4y2Ba.鉴于SSL的成功,绘制基于SSL的预训练框架gydF4y2Ba23gydF4y2Ba,gydF4y2Ba24gydF4y2Ba,gydF4y2Ba25gydF4y2Ba,gydF4y2Ba26gydF4y2Ba,gydF4y2Ba27gydF4y2Ba在过去的几年里一直在快速增长。它们捕获了二维图的拓扑结构,并在分子分析任务中显示出积极的效果。然而,由于它们在各种图中的通用性,导致忽视了化学分子独特的结构性质,如环和官能团。gydF4y2Ba

最近有许多演示学习作品gydF4y2Ba5gydF4y2Ba,gydF4y2Ba22gydF4y2Ba,gydF4y2Ba28gydF4y2Ba,gydF4y2Ba29gydF4y2Ba,gydF4y2Ba30.gydF4y2Ba,gydF4y2Ba31gydF4y2Ba,gydF4y2Ba32gydF4y2Ba,gydF4y2Ba33gydF4y2Ba考虑分子图的特点。Zhang等。gydF4y2Ba32gydF4y2Ba模型的聚类问题学习分子图案,和gnn编码的原子表示被分组成子图进行对比学习。Zhang等。gydF4y2Ba30.gydF4y2Ba设计自监督分子预训练框架,其前提任务是根据图上给定的顺序(深度优先搜索或宽度优先搜索)预测图元。Wang等。gydF4y2Ba5gydF4y2Ba提出了三种分子图结构增强模式,并通过对比学习对同一分子的不同增强进行对齐。Wang等。gydF4y2Ba33gydF4y2Ba并提出了一种分子学习的对比学习框架,不仅对分子对采样,还对基序对进行对比预训练。Wang等。gydF4y2Ba31gydF4y2Ba考虑到分子之间的化学反应关系,即,所有反应物的分子代表的总和应该等于所有产物的总和。尽管分子表征学习技术有所改进,但以往的工作仍未能解决以下问题和挑战:(1)如何充分保存和捕获分子结构?许多最新的分子学习方法gydF4y2Ba5gydF4y2Ba,gydF4y2Ba28gydF4y2Ba应用图增强构建不同视图,对比多个视图进行预训练。然而,一些通用的图数据增强(如边缘修改gydF4y2Ba34gydF4y2Ba或者图扩散gydF4y2Ba35gydF4y2Ba)往往会破坏分子的结构或属性,因此一些重要的化学性质极有可能被掩盖。除了整个拓扑结构外,基序也很有价值,对分子性质有重要影响。因此,保留完整的分子结构并直接纳入基序是分子学习的有益和挑战。(2)如何将更全面的信息融合到分子图表示中?随着GNN的发展gydF4y2Ba36gydF4y2Ba,gydF4y2Ba37gydF4y2Ba,gydF4y2Ba38gydF4y2Ba,gydF4y2Ba39gydF4y2Ba,gydF4y2Ba40gydF4y2Ba分子学习方法gydF4y2Ba29gydF4y2Ba,gydF4y2Ba31gydF4y2Ba利用GNN作为编码器骨干,其中节点在本地邻居之间流动信息,通过READOUT函数集成其所有节点表示来获得图表示。聚集邻里表示的模式缺乏全球规模。此外,READOUT操作只能将信息从低阶原子传递到高阶分子,而不能实现它们之间的相互作用。(3)如何设计自我监督预训练的借口任务?自监督预训练需要设计借口任务来优化骨干模型参数。借口任务在很大程度上影响了预训练模型的可迁移能力,这决定了模型在下游任务中能否达到令人满意的微调性能。因此,设计合理的借口任务以提高可迁移能力是自我监督预训练模型的关键。gydF4y2Ba

为了解决上述挑战,我们提出了一种用于分子性质预测的自监督学习框架,称为分层分子图自监督学习(HiMol)。数字gydF4y2Ba1gydF4y2Ba为HiMol的总体框架。HiMol由两个主要部分组成:分层分子图神经网络(HMGNN)和多级自监督预训练(MSP)。HMGNN提出了一种基于gnn的分层分子编码器,旨在解决前两个挑战。为了更好地探索分子图独特的内部化学结构,我们改进了分解分子基序结构的规则。分子基序表示一个分子的子结构,它通常包含许多化学特征。例如,羧基通常表示酸性。基序分解规则符合化学准则,避免破坏化学特性。我们在分子图中添加motif作为节点,以挖掘隐含的语义信息。此外,我们增加了一个图级节点,通过与正常节点和motif一起训练来学习分子图表示,以取代READOUT函数。图级节点从所有节点收集信息,并通过图级节点将全局信息传输回节点。 This circulation realizes the information interaction between different orders, which helps the model to learn more comprehensive representations. MSP designs multi-level pretext tasks as supervision signals of pre-training. Specifically, MSP designs three generative tasks that predict bond links, atom types, and bond types with the atom representations; MSP designs two predictive tasks that predict the number of atoms and bonds with the molecule representation. Compared with single-signal pre-training frameworks, multi-level pretext tasks help fuse more molecular information into molecule representations from diverse perspectives.

综上所述,我们HiMol的优势如下:gydF4y2Ba

HiMol构建了一个层次GNN来编码分子。它便于将多阶信息整合到分子表示中。据我们所知,HiMol是第一个编码节点-基序-图层次信息的分子表示学习方法。gydF4y2Ba

HiMol基于化学规则构建基序,在不破坏化学结构的情况下挖掘分子亚结构的特征。gydF4y2Ba

HiMol增加了一个图级节点来模拟分子图表示。它使分子图表示法直接参与训练,实现局部特征和全局特征的双向传递。gydF4y2Ba

HiMol根据分子的层次表示设计多级自我监督的预训练任务。它提高了预训练框架的可转移潜力,并有助于学习更多有信息的分子表示。gydF4y2Ba

HiMol在包括分类和回归在内的下游分子性质预测任务中优于先进水平(SOTA)。这证明了我们提出的HiMol的有效性。gydF4y2Ba

结果gydF4y2Ba

HiMol框架gydF4y2Ba

我们的HiMol提出了一个自我监督的预训练框架来编码分子图的层次表示。HiMol主要包括分层分子图神经网络(HMGNN)和多级自监督预训练(MSP)。gydF4y2Ba

给定一个分子的SMILES,我们首先将它转换成一个图gydF4y2Ba\ (G = \左(V E \) \)gydF4y2Ba基于RDKITgydF4y2Ba41gydF4y2Ba,在那里gydF4y2BaVgydF4y2Ba而且gydF4y2BaEgydF4y2Ba分别表示原子和键集。然后分解gydF4y2BaGgydF4y2Ba变成一系列的主题gydF4y2Ba\ ({V} _ {{{{{rm \ {m}}}}}} = \左\ {{V} _ {{{{{rm \ {m}}}}}} ^ {1}, {V} _ {{{{{rm \ {m}}}}}} ^{2},…,{V} _ {{{{{rm \ {m}}}}}} ^ {k} \右\}\)gydF4y2Ba,gydF4y2BakgydF4y2Ba是母题的数量。母题的分解在金砖国家的基础上又增加了一个规则gydF4y2Ba42gydF4y2Ba,即打破较大的环片段,并选择其最小环作为生成的母题。所有母题节点gydF4y2BaVgydF4y2Ba米gydF4y2Ba都被纳入gydF4y2BaVgydF4y2Ba,以及对应原子和图案之间的边gydF4y2BaEgydF4y2Ba米gydF4y2Ba被链接和合并成gydF4y2BaEgydF4y2Ba.此外,我们还增加了一个图级节点gydF4y2BaVgydF4y2BaggydF4y2Ba,同时,边缘之间的所有主题和gydF4y2BaVgydF4y2BaggydF4y2Ba被追加到初始图中gydF4y2BaGgydF4y2Ba.增广图gydF4y2Ba\ (\ widetilde {G} \)gydF4y2Ba输入到gnn以学习分层表示,包括原子级表示gydF4y2Ba\({{{{{{{{\ 男朋友{H }}}}}}}}}_{{{{{{{{\ rm{一 }}}}}}}}}\ 在{{\ mathbb {R}}} ^ {V | | \ * d} \)gydF4y2Ba,图案级表示gydF4y2Ba\({{{{{{{{\ 男朋友{H }}}}}}}}}_{{{{{{{{\ rm{米 }}}}}}}}}\ 在{{\ mathbb {R}}} ^ {k \ * d} \)gydF4y2Ba,以及图级表示gydF4y2Ba\({{{{{{{{\ 男朋友{H }}}}}}}}}_{{{{{{{{\ rm {g }}}}}}}}}\ 在{{\ mathbb {R}}} ^ {d} \)gydF4y2Ba.在MSP过程中,原子级表示法用于预测原子类型、键连接和键类型;图级表示法用于预测原子和键的数量。交叉熵损失和平滑L1损失分别用于优化原子级和分子级的学习。gydF4y2Ba

至于下游任务的微调,图级表示通过2层多层感知器(MLP)来预测分子性质。预训练的GNN权重被转移到微调模型中,并在标签的监督下与MLP参数一起继续更新。更多关于HiMol方法的细节见Methods。gydF4y2Ba

分子性质预测gydF4y2Ba

为了评估HiMol对分子性质预测的有效性,我们对来自MoleculeNet的不同数据集进行了分类和回归任务。表格gydF4y2Ba1gydF4y2Ba报告二元分类任务ROC-AUC(%)结果的均值和标准差。我们将观察到的结果总结如下。(1)我们的HiMol在六个数据集中的四个数据集上实现了最强的性能。对于其余的数据集,HiMol在Tox21上仍然具有竞争力的性能。虽然MolCLR在ClinTox上表现出了显著的效果,但它在其他数据集上的表现并不令人满意。平均而言,HiMol比最佳基线提高了2.4%。实验结果证明了我们的分层图学习模型HiMol的优越性和有效性。(2)在所有SOTA方法中,基于motif的模型G_Motif和MGSSL的性能优于其他基线,说明motif结构的捕获在分子图学习中起着重要作用。但是,它们仅使用motif预测作为预训练的借口任务,gnn提取的隐藏表示在下游任务的微调过程中并不直接包含motif信息。我们的HiMol通过GNN主干编码motif结构,这有利于分子表示,在微调过程中更好地学习和预测分子的内部性质。 (3) We give two different scales of HiMol models, in which the layer numbers of GIN for HiMol (SMALL) and HiMol (LARGE) are respectively 3 and 5. The LARGE version performs slightly better, which may be explained as the deeper GNN being able to capture more structural information.

回归结果见表gydF4y2Ba2gydF4y2Ba.根据MoleculeNet的建议,平均绝对误差(MAE)被用作物理化学数据集(ESOL, FreeSlov和Lipophilicity)的评估指标,而均方根误差(RMSE)是量子力学数据集(QM7, QM8和QM9)的指标。表的观察结果gydF4y2Ba2gydF4y2Ba总结如下。MoCL的回归结果gydF4y2Ba28gydF4y2Ba由于在QM9上预训练过程中计算相似矩阵的开销较大,所以在官方论文中没有给出相应的结果。(1) HiMol在六个数据集中的五个数据集上优于所有基线,并在剩余的QM8上达到具有竞争力的性能。值得注意的是,在具有挑战性的数据集QM9上,MAE比最强基线下降了55.5%。(2)与分类任务的结果相似,在回归任务中,LARGE版本相对于small版本具有较小的优势。gydF4y2Ba

分子表征的可视化gydF4y2Ba

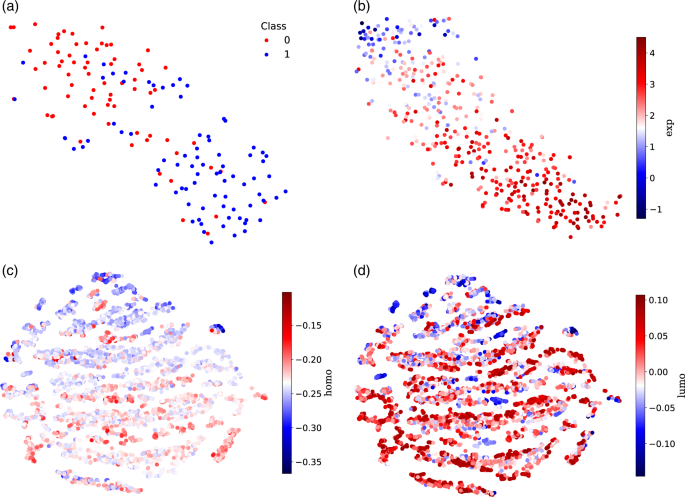

为了直观地展示HiMol学习到的表示,我们使用t-SNEgydF4y2Ba43gydF4y2Ba将它们投射到二维空间和不同的颜色来区分分子属性标签。请注意,我们只是在测试集中可视化微调的分子表示,其中不包括基本真理。从无花果。gydF4y2Ba2gydF4y2Ba,在分类和回归任务中,分子表现形式都按照它们的标签分组。例如,在图中。gydF4y2Ba2gydF4y2Baa, Class标签表示BACE-1抑制剂结合的二元结果。标记为0和1的分子分别在左上方和右下方分组。类似地,在图中。gydF4y2Ba2gydF4y2BaB,从左上到右下,分子的exp值越来越高。此外,在图。gydF4y2Ba2gydF4y2Bac, d,可以观察到QM9上分子的两个重要性质的可视化呈现具有高度的一致性。图中的可视化。gydF4y2Ba2gydF4y2Ba证明我们的HiMol可以提取分子的内部性质。在其他数据集中也可以观察到类似的结论(见补充图)。gydF4y2Ba1)gydF4y2Ba.gydF4y2Ba

为了进一步证明我们的预训练框架的有效性,我们将在补充图中没有预训练的下游任务中微调的分子表示可视化。gydF4y2Ba2gydF4y2Ba.与图相比。gydF4y2Ba2gydF4y2Ba,未进行预训练的可视化结果对于不同性质的分子来说是混乱的。预训练提高了HMGNN编码器的性能,有利于在下游任务中学习更多的化学性质。gydF4y2Ba

分子表征相似性排序gydF4y2Ba

为了进一步研究通过HiMol预训练的分子表示中包含的语义信息,我们评估了查询分子与其他分子之间的相似性,并绘制出最相似的前5个分子。查询分子之间的余弦相似度gydF4y2Ba问gydF4y2Ba候选分子gydF4y2BacgydF4y2Ba计算公式如下:gydF4y2Ba

在哪里gydF4y2Ba\({{{{{{{{\ 男朋友{H }}}}}}}}}_{{{{{{{{\ rm {g }}}}}}}}}^{ 问}\ {{\ mathbb {R}}} ^ {d} \)gydF4y2Ba而且gydF4y2Ba\({{{{{{{{\ 男朋友{H }}}}}}}}}_{{{{{{{{\ rm {g }}}}}}}}}^{ R c} \在{{\ mathbb {}}} ^ {d} \)gydF4y2Ba分别是查询分子和候选分子的图表示。然后对所有候选分子的相似度进行排序,查询ZINC9452931的前5个分子如图所示。gydF4y2Ba3.gydF4y2Ba.从图中我们可以观察到,这五种分子的结构和官能团与查询相似。具体来说,前5个相似的分子拥有查询的所有原子类型,即C, H, N, O, s,并且所有分子中都存在两个环共用一条边的结构。Top@1分子不仅具有与查询相似的环结构,而且具有NC(=O)和C(=O)等相同的链结构。分子表示相似性排序实验表明,我们的框架HiMol可以学习含有化学语义信息的分子表示。同时,对基序进行编码有利于识别功能基团、环等分子亚结构。关于其他查询分子的更多结果见补充图。gydF4y2Ba3.gydF4y2Ba.gydF4y2Ba

微调模式分析gydF4y2Ba

为了研究不同的微调策略对模型预测任务的影响,我们探索了冻结模式和完全微调模式。它们都继承了预先训练好的分层分子图神经网络的权值。冻结模式冻结HMGNN的参数,只更新下游分类器的权值,而全微调模式在微调时端到端训练HMGNN和分类器的所有权值。此外,我们在没有预训练的情况下评估HiMol和香草GINgydF4y2Ba38gydF4y2Ba,通过受监督的下游任务直接训练它们。表格gydF4y2Ba3.gydF4y2Ba显示了所有方法的两种不同版本,其中SMALL版本和LARGE版本分别用3层和5层gnn编码分子图。从结果可以看出:(1)完全微调模式比冻结模式更有优势,这表明我们提出的HMGNN在预测任务中起决定性作用;(2)未经预训练的Himol相对于GIN表现更好,说明HMGNN具有提取更丰富结构信息的能力;(3) HiMol在预训练后获得了更好的性能,验证了我们提出的多级自监督预训练策略可以有效训练模型参数并将知识传递到下游数据。gydF4y2Ba

数字gydF4y2Ba4gydF4y2Ba进一步显示了上述四种模式的训练分类和测试分类ROC-AUC曲线。可以观察到,与其他方法相比,完整的HiMol可以更快地收敛到最佳性能。此外,预训练的方法(HiMol及其冻结模式)在训练曲线和测试曲线方面比其他两种未进行预训练的模式具有更好的稳定性,说明我们的预训练框架提高了微调的稳定性。gydF4y2Ba

训练前的消融研究gydF4y2Ba

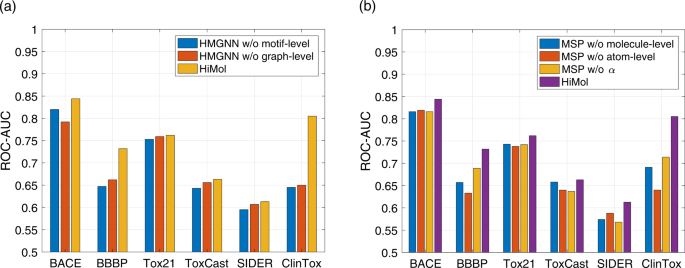

为了分析我们提出的HiMol框架每个部分的有效性,我们在预训练过程中对HMGNN和MSP进行了消融实验。数字gydF4y2Ba5gydF4y2Ba说明了HMGNN和MSP的烧蚀实验结果。gydF4y2Ba

在无花果。gydF4y2Ba5gydF4y2Baa,我们将HiMol与两个预训练版本进行比较。HMGNN w/o motif-level表示分子图只增加图级节点和节点图边,而不分解motif。HMGNN w/o图级通过对motif级表示执行均值池来获得图级表示。我们可以观察到以下结论:(1)HiMol去除基序的性能在所有基准上都变差,这意味着编码基序在分子表征学习中的重要作用。HiMol对motif进行分解,学习层次表示,有利于学习更多的分子结构特征和功能。(2)用图池化的压缩表示代替图级节点表示,也使分子性质预测性能略有下降。增强一个图级节点优于均值池函数,因为它可以通过motif节点间接学习多阶特征,并且可以在训练过程中将全局信息传递给所有原子节点。相互之间,原子节点不仅集成了局部邻域信息,还捕获了子结构和全局图信息。这些正常节点与图级节点之间的多层次交互提高了HMGNN的学习性能。gydF4y2Ba

MSP的消融版本如图所示。gydF4y2Ba5gydF4y2Bab.无原子级的MSP在预训练中只包含图级的借口任务(原子和键的数量)。类似地,图级MSP只包含原子级的借口任务(绑定链接、原子类型和绑定类型)。MSP w / ogydF4y2BaαgydF4y2Ba简单地求和所有的损失值,删除gydF4y2BaαgydF4y2Ba要平衡的权重参数。可以观察到,与单一借口任务相比,多层次自我监督任务的组合提高了预训练的全面性迁移能力。此外,可学习的权重gydF4y2BaαgydF4y2Ba调整不同部分损失的重要性,可以更好地协调多级任务之间的关系,提高预训练的性能。gydF4y2Ba

讨论gydF4y2Ba

主题编码gydF4y2Ba

首先,我们建议在学习原子表示的同时对构造的motif进行编码。HiMol通过基序来挖掘分子的子结构。现有的分子表示学习方法有很多gydF4y2Ba29gydF4y2Ba,gydF4y2Ba30.gydF4y2Ba考虑母题结构。他们通常将大规模数据库中的分子分解为motif,建立motif字典,然后在分子表示学习的预训练过程中,将motif预测作为自监督的借口任务。然而,这些方法都存在一些缺点:(1)当构造的基序字典较大时,基序预测的计算量较大。(2)母题仅作为自监督信号,难以被隐藏表征直接纳入。我们在编码器部分对每个分子中包含的motif进行编码,直接将motif结构集成到隐藏表示中。此外,增加基序级节点能更好地捕捉原子与基序之间的隶属关系。gydF4y2Ba

图像编码gydF4y2Ba

除了图案级节点,我们还在分子图中增加了一个图级节点,该节点参与聚集过程以提取分子表示。大多数分子学习方法使用香草gnn作为骨干,并通过READOUT函数将节点表示压缩为图表示,即MAX, SUM和MEAN等图池方法。gnn的处理过程在附注中介绍gydF4y2Ba1gydF4y2Ba.它可以方便地处理不同大小的图数据,但图级表示无法参与学习。伯特模型gydF4y2Ba11gydF4y2Ba,gydF4y2Ba44gydF4y2Ba提出在序列上附加一个标记,其表示被视为序列级特征。提到BERT, GraphormergydF4y2Ba45gydF4y2Ba向图中添加一个虚拟节点,该节点与所有节点链接并更新,虚拟节点的特征是图表示。受上述工作成功的启发,我们增加了一个图级节点,通过参与所有原子的聚合和更新来提取分子图表示。然而,相关方法只是将图级节点与普通节点连接起来,不利于获取子图结构。为了集成motif节点,我们将图级节点与motif节点连接以实现分层聚合。与READOUT相比,我们的HiMol在加入分子基序结构后实现了图节点的训练和更新,并实现了与多阶节点的交互。gydF4y2Ba

结论gydF4y2Ba

在本文中,我们提出了层次分子图自监督学习(HiMol)来学习分子表示。具体而言,我们设计了分层分子图神经网络(HMGNN)骨干来编码节点-基序-图的层次表示,挖掘基序隐含的化学语义信息,实现多阶特征间的交互。此外,我们将多级分子依赖任务构建为自监督信号,从多个角度捕获更全面的信息。大量的分子性质预测实验表明,HiMol较SOTA方法有很大的改进。gydF4y2Ba

分子表示的优越性能反映了我们HiMol框架的潜力,并且在HiMol的基础上有有趣和有前途的未来工作。(1)除二维图形外,结合不同维度的分子特征。(2)模拟分子生成过程,将模型扩展到分子生成和优化任务。gydF4y2Ba

方法gydF4y2Ba

分层分子图神经网络gydF4y2Ba

提出了一种分层分子图神经网络(HMGNN)来编码和表示分子图,主要包括三个部分:(1)基序构建;(2)增广图构造;(3)分层表示编码器。gydF4y2Ba

首先,我们将每个输入分子图分解成一组motif。金砖算法是一种传统的分子碎片图方法,它设计化学规则来破坏化学键。具体来说,BRICS根据键能不能结合,在结构上将分子分解为多个功能片段。然而,金砖基于有限的化学规则拆分分子,导致分解的粗粒度。在金砖四国分解后,一些大型主题仍然包含一些更一般和功能的子结构进行划分。因此,我们在BRICS的基础上增加了一个分解规则,即将多个由共同化学键连接的环子结构分解为最小环。数字gydF4y2Ba6gydF4y2Ba阐述了母题构建的过程。gydF4y2Ba

所有获得的图案都作为节点添加gydF4y2BaVgydF4y2Ba米gydF4y2Ba分子图。自然,节点图案的边缘gydF4y2BaEgydF4y2Ba米gydF4y2Ba在每个motif节点和它覆盖的所有原子节点之间添加。由于最终输出是分子图表示,我们构造了一个图级节点gydF4y2BaVgydF4y2BaggydF4y2Ba进入分子图,并将其与所有基序节点连接,形成基序图边gydF4y2BaEgydF4y2BaggydF4y2Ba.最后的增广图表示为:gydF4y2Ba

在构造图上gydF4y2Ba\ (\ widetilde {G} \)gydF4y2Ba,我们使用GNN编码分层分子表示。图同构网络(GIN)gydF4y2Ba38gydF4y2Ba是应用最广泛的分子图编码表示方法。受此启发,我们应用GIN作为HiMol的骨干模型,HiMol的聚合模式gydF4y2BalgydF4y2BatgydF4y2BahgydF4y2Ba层数如下:gydF4y2Ba

在哪里gydF4y2Ba\({{{{{{{{\ rm{延时 }}}}}}}}}_{{{{{{{{\ rm{一 }}}}}}}}}^{ l} \)gydF4y2Ba而且gydF4y2Ba\({{{{{{{{\ rm{延时 }}}}}}}}}_{{{{{{{{\ rm {b }}}}}}}}}^{ l} \)gydF4y2Ba表示原子和键特征跃迁的MLPgydF4y2BalgydF4y2Ba层,分别gydF4y2Ba\({{{{{{{{\ 男朋友{X }}}}}}}}}_{ 紫外线 }^{{{{{{{{\ rm {b }}}}}}}}}\)gydF4y2Ba的键合特征gydF4y2BaugydF4y2BavgydF4y2Ba,gydF4y2Ba\({{{{{{{{\ 男朋友{h }}}}}}}}}_{ v} ^ {0 }={{{{{{{{\ 男朋友{X }}}}}}}}}_{ v }^{{{{{{{{\ rm{一 }}}}}}}}}\)gydF4y2Ba输入原子的特征是gydF4y2BavgydF4y2Ba.原子和键的详细输入特征见补充表gydF4y2Ba1gydF4y2Ba.与其他基线不同的是,我们HiMol的初始分子特征包含了原子节点的程度以及键是否成环,这包含了更多的分子结构信息。我们提出的HMGNN可以同时编码分子图以获得多级表示,包括原子级、基序级和分子级表示。学习到的分子水平表示可以直接用于下游任务,而不需要READOUT操作。gydF4y2Ba

多层次自我监督的预培训gydF4y2Ba

利用HMGNN对分层表示进行编码后,设计生成式和预测式借口任务,执行多级自监督预训练(Multi-level Self-supervised pretraining, MSP)。不同借口任务对应的自我监督学习类型在补充说明中有所描述gydF4y2Ba2gydF4y2Ba.gydF4y2Ba

对于原子级表示,我们设计了三个生成任务,包括键链接、原子类型和键类型,旨在重建图结构和属性。具体来说,三个具有ReLU激活函数的2层mlp分别投射原子级表示来预测三个生成任务。交叉熵损失用于优化原子级表示,如下所示:gydF4y2Ba

在哪里gydF4y2BaygydF4y2Ba我gydF4y2BajgydF4y2Ba之间的链接。gydF4y2BavgydF4y2Ba我gydF4y2Ba而且gydF4y2BavgydF4y2BajgydF4y2Ba,gydF4y2BaygydF4y2BavgydF4y2Ba,gydF4y2BakgydF4y2Ba= 1表示节点的原子类型gydF4y2BavgydF4y2Ba是gydF4y2BakgydF4y2Ba,gydF4y2BaygydF4y2BaegydF4y2Ba,gydF4y2BakgydF4y2Ba= 1表示边的键合类型gydF4y2BaegydF4y2Ba是gydF4y2BakgydF4y2Ba.相应的gydF4y2Ba\ ({y} \ \帽子)gydF4y2Ba是预测值。gydF4y2BaKgydF4y2Ba一个gydF4y2BatgydF4y2BaogydF4y2Ba米gydF4y2Ba而且gydF4y2BaKgydF4y2BabgydF4y2BaogydF4y2BangydF4y2BadgydF4y2Ba是原子类型和键类型的数量。gydF4y2Ba

对于图级表示,对分子的整体性质执行两个预测任务,即原子和键的数量。同样地,使用两个分别具有softplus激活函数的2层mlp来预测图级任务。基于SmoothL1损失,预测任务损失如式(gydF4y2Ba7gydF4y2Ba)及(gydF4y2Ba8gydF4y2Ba).gydF4y2Ba

在哪里gydF4y2BaygydF4y2Ba一个gydF4y2Ba而且gydF4y2BaygydF4y2BabgydF4y2Ba分别是原子数和键数;gydF4y2Ba\ ({y} \ \帽子)gydF4y2Ba是预测值。gydF4y2Ba补充方法gydF4y2Ba从表示法描述转换过程gydF4y2BaHgydF4y2Ba到预测值gydF4y2BaygydF4y2Ba.最后,我们添加一个可学习的向量权值gydF4y2Ba\(左\α= \[{\α}_{1},{\α}_{2},{\α}_{3},{\α}_{4},{\α}_{5}\右]\)gydF4y2Ba采用softmax函数归一化,平衡多个损失。总体目标计算如下:gydF4y2Ba

数据集gydF4y2Ba

对于HiMol的预训练,我们使用了来自ZINC15的250K未标记分子样本gydF4y2Ba46gydF4y2Ba数据集。为了评估HiMol的有效性,我们对来自MoleculeNet的12个数据集进行了分子性质预测实验gydF4y2Ba47gydF4y2Ba,包括6个分类任务数据集和6个回归任务数据集。通过scaffold-split将所有下游数据集分成80/10/10%进行训练/验证/测试,该方法根据分子结构进行拆分,比随机拆分更具挑战性。各数据集的统计数据汇总在补充表中gydF4y2Ba2gydF4y2Ba.gydF4y2Ba

基线gydF4y2Ba

为了评估我们提出的HiMol的有效性,我们进行了不同类型的自我监督学习SOTA作为基准。我们比较了各种通用图学习方法,包括GraphSAGEgydF4y2Ba39gydF4y2Ba, GPT_GNNgydF4y2Ba48gydF4y2Ba, AttributeMaskgydF4y2Ba49gydF4y2Ba, ContextPredgydF4y2Ba49gydF4y2Ba, InfoGraphgydF4y2Ba50gydF4y2Ba, GraphLoGgydF4y2Ba26gydF4y2Ba, GraphCLgydF4y2Ba25gydF4y2Ba、JOAOgydF4y2Ba51gydF4y2Ba.此外,我们比较了几种专门为分子图设计的方法,即MoCLgydF4y2Ba28gydF4y2Ba, MolCLRgydF4y2Ba5gydF4y2Ba, G_MotifgydF4y2Ba29gydF4y2Ba、MGSSLgydF4y2Ba30.gydF4y2Ba.基线的详细描述见补充说明gydF4y2Ba3.gydF4y2Ba, SSL类型汇总见“补充表”gydF4y2Ba3.gydF4y2Ba.gydF4y2Ba

实验配置gydF4y2Ba

所有实验均在Linux服务器上进行,使用Nvidia GeForce GTX 1080 Ti GPU和Intel(R) Xeon(R) CPU E5-2620 v4 @ 2.10GHz。在预训练阶段,HiMol使用Adam优化器运行100个epoch,学习率为0.001。我们训练了LARGE和SMALL版本,以3层和5层GIN作为HMGNN的骨干。配置GIN骨干的退出率为0.5。批大小设置为32,数据装载器的工人数量为8。所有层次的隐藏表示都是512维的。gydF4y2Ba

在优化阶段,我们实现了一个以ELU激活函数为分类器的2层MLP。预训练HMGNN和分类器的权重均由Adam优化器优化,学习速率分别为1e-4 ~ 1e-3。对于每个下游任务,我们对100个epoch进行微调,并报告五次运行的平均测试结果。批大小为32个,工人人数为4人。嵌入维数为512,与预训练阶段相同。辍学率在[0.5,0.7]范围内调整。微调过程中每个数据集的参数设置在补充表中报告gydF4y2Ba4gydF4y2Ba.gydF4y2Ba

为了公平起见,我们在同一个数据集ZINC15上根据它们的官方代码预训练所有基线,MoCL除外gydF4y2Ba28gydF4y2Ba.MoCL没有实现迁移学习,预训练时计算ZINC15数据集的相似矩阵计算量很大。因此,我们采用与正式工作相同的方式:对每个下游数据集进行预训练,然后对同一数据集进行微调,以完成分子性质预测任务。所有基线在下游数据集上保持相同的分割比例和方式。gydF4y2Ba

数据可用性gydF4y2Ba

本文所有相关数据均为公开数据。用于预训练的ZINC数据集可以从gydF4y2Bahttps://github.com/zaixizhang/MGSSL/tree/main/motif_based_pretrain/data/zincgydF4y2Ba如MGSSL中所述gydF4y2Ba30.gydF4y2Ba.所有用于微调的下游数据集都可以从MoleculeNet网站下载gydF4y2Bahttps://github.com/deepchem/deepchem/tree/master/deepchem/molnet/load_functiongydF4y2Ba.gydF4y2Ba

代码的可用性gydF4y2Ba

HiMol的实现可以在gydF4y2Bahttps://github.com/ZangXuan/HiMolgydF4y2Ba.gydF4y2Ba

参考文献gydF4y2Ba

Kotsias P.-C。et al。用描述符条件递归神经网络直接引导新生分子生成。gydF4y2BaNat,马赫。智能。gydF4y2Ba2gydF4y2Ba, 254-265(2020)。gydF4y2Ba

Vamathevan等。机器学习在药物研发中的应用。gydF4y2BaNat. Rev.药物发现gydF4y2Ba18gydF4y2Ba, 463-477(2019)。gydF4y2Ba

LeCun, Y., Bengio, Y. & Hinton, G.深度学习。gydF4y2Ba自然gydF4y2Ba521gydF4y2Ba, 436-444(2015)。gydF4y2Ba

李松,周俊,徐涛,窦东,熊海辉。几何图对比学习在分子性质预测中的应用。在gydF4y2BaAAAI人工智能会议gydF4y2Ba, Vol. 36, 4541-4549(2022)。gydF4y2Ba

王勇,王军,曹哲,王俊杰。基于图神经网络的分子表征对比学习。gydF4y2BaNat,马赫。智能。gydF4y2Ba4gydF4y2Ba, 279-287(2022)。gydF4y2Ba

葛鲍尔,盖博,盖斯特格,赫斯曼,s.s., Müller, k.r。& Schütt, K. T.三维分子结构逆设计与条件生成神经网络。gydF4y2BaCommun Nat。gydF4y2Ba13gydF4y2Ba, 1-11(2022)。gydF4y2Ba

李,C.等。基于几何的深度约束变分自编码器分子生成。gydF4y2BaIEEE反式。神经。学习系统gydF4y2Ba.1 - 10(2022)。gydF4y2Ba

童,等。全新药物设计的生成模型。gydF4y2Ba医学。化学。gydF4y2Ba64gydF4y2Ba, 14011-14027(2021)。gydF4y2Ba

陈志强,闵敏荣,宁旭。基于单片段修饰的分子优化深度生成模型。gydF4y2BaNat,马赫。智能。gydF4y2Ba3.gydF4y2Ba, 1040-1049(2021)。gydF4y2Ba

Sutskever, I., Vinyals, O. & Le, Q. V.序列到序列的神经网络学习。在gydF4y2Ba第27届神经信息处理系统国际会议进程gydF4y2Ba, Vol. 2, 3104-3112(2014)。gydF4y2Ba

肯顿,j.d.m.w。C. & Toutanova, L. K. BERT:深度双向转换器的语言理解预训练。在gydF4y2Ba2019年计算语言学协会北美分会会议:人类语言技术gydF4y2Ba, Vol. 1, 4171-4186(2019)。gydF4y2Ba

瓦斯瓦尼,A.等人。注意力就是你所需的一切在gydF4y2Ba第31届神经信息处理系统国际会议进程gydF4y2Ba, 6000-6010(2017)。gydF4y2Ba

韦宁格,D. Smiles,化学语言和信息系统。1.方法和编码规则的介绍。gydF4y2Baj .化学。正无穷。第一版。科学。gydF4y2Ba28gydF4y2Ba, 31-36(1988)。gydF4y2Ba

Krenn, M, Häse, F., Nigam, A., Friederich, P. & Aspuru-Guzik, A.自引用嵌入字符串(自拍):100%鲁棒分子字符串表示。gydF4y2Ba马赫。学习。科学。抛光工艺。gydF4y2Ba1gydF4y2Ba, 045024(2020)。gydF4y2Ba

Cho, K.等。使用RNN编码器-解码器学习短语表示,用于统计机器翻译。在gydF4y2Ba2014自然语言处理经验方法会议(EMNLP)gydF4y2Ba(2014)。gydF4y2Ba

何克瑞特,史密德胡伯,J.长短期记忆。gydF4y2Ba神经第一版。gydF4y2Ba9gydF4y2Ba, 1735-1780(1997)。gydF4y2Ba

郑生,颜晓霞,杨艳,徐娟。基于自注意机制的微笑句法分析及其结构-属性关系识别。gydF4y2Baj .化学。正无穷。模型。gydF4y2Ba59gydF4y2Ba, 914-923(2019)。gydF4y2Ba

徐震,王胜,朱峰,黄俊。Seq2seq指纹:一种非监督深度分子嵌入药物发现。在gydF4y2Ba第八届ACM生物信息学、计算生物学和健康信息学国际会议gydF4y2Ba, 285-294(2017)。gydF4y2Ba

薛,D.等。X-mol:分子理解和多样化分子分析的大规模预训练。gydF4y2Ba科学。牛gydF4y2Ba.gydF4y2Ba67gydF4y2Ba, 899-902(2022)。gydF4y2Ba

Chithrananda, S., Grand, G. & Ramsundar, B. ChemBERTa:分子性质预测的大规模自我监督预训练。预印在gydF4y2BaarXivgydF4y2Bahttps://arxiv.org/abs/2010.09885gydF4y2Ba(2020)。gydF4y2Ba

Gilmer, J., Schoenholz, s.s., Riley, p.f., Vinyals, O. & Dahl, g.e.量子化学的神经信息传递。在gydF4y2Ba第34届国际机器学习会议gydF4y2Ba, Vol. 70, 1263-1272 (PMLR 2017)。gydF4y2Ba

Ishida, S., Miyazaki, T., Sugaya, Y. & Omachi, S.用于化学性质估计的多特征提取路径的图神经网络。gydF4y2Ba分子gydF4y2Ba26gydF4y2Ba, 3125(2021)。gydF4y2Ba

Velickovic, P.等人。深度图信息max。gydF4y2BaICLR(海报)gydF4y2Ba2gydF4y2Ba, 4(2019)。gydF4y2Ba

邱,J.等。Gcc:图神经网络预训练的图对比编码。在gydF4y2Ba第26届ACM SIGKDD知识发现与数据挖掘国际会议gydF4y2Ba, 1150-1160(2020)。gydF4y2Ba

你,y等人。图形对比学习与增强。gydF4y2Ba神经导过程。系统。gydF4y2Ba33gydF4y2Ba, 5812-5823(2020)。gydF4y2Ba

徐敏,王宏,倪斌,郭宏,唐杰。基于局部和全局结构的自监督图级表示学习。在gydF4y2Ba机器学习国际会议gydF4y2Ba, 11548-11558(2021)。gydF4y2Ba

刘,S.等。用三维几何预训练分子图表示。在gydF4y2Ba第十届学习表征国际会议论文集gydF4y2Ba(2022)。gydF4y2Ba

孙敏,邢娟,王海华,陈波,周俊。基于知识感知对比学习的分子图谱数据驱动。在gydF4y2Ba第27届ACM SIGKDD知识发现与数据挖掘会议进程gydF4y2Ba, 3585-3594(2021)。gydF4y2Ba

容,Y.等。大规模分子数据的自监督图转换器。gydF4y2Ba神经导过程。系统。gydF4y2Ba33gydF4y2Ba, 12559-12571(2020)。gydF4y2Ba

张,Z,刘,问王,H,陆,C.-K c & Lee。基于图案的图自监督学习用于分子性质预测。gydF4y2Ba神经导过程。系统。gydF4y2Ba34gydF4y2Ba, 15870-15882(2021)。gydF4y2Ba

王,H.等。化学反应感知分子表示学习。在gydF4y2Ba学习表征国际会议进程gydF4y2Ba(2021)。gydF4y2Ba

张珊珊,胡志刚,孙杨。图形表征的主题驱动对比学习。预印在gydF4y2BaarXivgydF4y2Bahttps://arxiv.org/abs/2012.12533gydF4y2Ba(2020)。gydF4y2Ba

王勇,马嘉尔,梁超,和Barati Farimani, A.通过错误负缓解和分解片段对比改进分子对比学习。gydF4y2Baj .化学。正模型。gydF4y2Ba62gydF4y2Ba, 2713-2725(2022)。gydF4y2Ba

曾俊杰,谢平。基于对比自监督学习的图形分类方法。在gydF4y2BaAAAI人工智能会议gydF4y2Ba, Vol. 35, 10824-10832(2021)。gydF4y2Ba

Klicpera, J., Weißenberger, S. & Günnemann, S.扩散改善了图学习。在gydF4y2Ba第33届神经信息处理系统国际会议论文gydF4y2Ba, 13366-13378(2019)。gydF4y2Ba

Velickovic, P.等人。绘制注意力网络图。在gydF4y2BaProc。gydF4y2Ba第六届学习表征国际会议gydF4y2Ba(ICLR, 2018)。gydF4y2Ba

Kipf, T. N. & Welling, M.半监督分类与图卷积网络。在gydF4y2Ba第五届学习表征国际会议进程gydF4y2Ba(ICLR, 2017)。gydF4y2Ba

Xu, K., Hu, W., Leskovec, J. & Jegelka, S.图神经网络有多强大?在gydF4y2Ba学习表征国际会议进程gydF4y2Ba(2018)。gydF4y2Ba

张志刚,张志刚,张志刚。大型图的归纳表示学习。gydF4y2Ba神经导过程。系统。gydF4y2Ba30.gydF4y2Ba(2017)。gydF4y2Ba

刘明,高宏,纪生。面向更深层次的图神经网络。在gydF4y2Ba第26届ACM SIGKDD知识发现与数据挖掘国际会议gydF4y2Ba, 338-348(2020)。gydF4y2Ba

RDkit:开源化学信息学软件。gydF4y2Bahttps://www.rdkit.orggydF4y2Ba.gydF4y2Ba

Degen, J., Wegscheid-Gerlach, C., Zaliani, A. & Rarey, M.关于编译和使用“类药物”化学片段空间的艺术。gydF4y2BaChemMedChemgydF4y2Ba3.gydF4y2Ba, 1503-1507(2008)。gydF4y2Ba

van der Maaten, L. & Hinton, G.使用t-SNE可视化数据。gydF4y2Baj·马赫。学习。Res。gydF4y2Ba9gydF4y2Ba, 2579-2605(2008)。gydF4y2Ba

刘,Y.等。RoBERTa:一种稳健优化的BERT预训练方法。预印在gydF4y2BaarXivgydF4y2Bahttps://arxiv.org/abs/1907.11692gydF4y2Ba(2019)。gydF4y2Ba

Ying, C.等。变压器在图形表示方面真的表现不好吗?gydF4y2Ba神经导过程。系统。gydF4y2Ba34gydF4y2Ba, 28877-28888(2021)。gydF4y2Ba

斯特林,T. & Irwin, J. J.锌15配体的发现。gydF4y2Baj .化学。正无穷。模型。gydF4y2Ba55gydF4y2Ba, 2324-2337(2015)。gydF4y2Ba

吴,Z.等。分子机器学习的基准。gydF4y2Ba化学。科学。gydF4y2Ba9gydF4y2Ba, 513-530(2018)。gydF4y2Ba

胡卓,董勇,王凯,张国伟。& Sun Y. GPT-GNN:图神经网络的生成式预训练。在gydF4y2Ba第26届ACM SIGKDD知识发现与数据挖掘国际会议gydF4y2Ba, 1857-1867(2020)。gydF4y2Ba

Hu, W.等。预训练图神经网络的策略。在gydF4y2Ba学习表征国际会议进程gydF4y2Ba(2019)。gydF4y2Ba

太阳,F.-Y。,Hoffman, J., Verma, V. & Tang, J. InfoGraph: Unsupervised and semi-supervised graph-level representation learning via mutual information maximization. In学习表征国际会议进程gydF4y2Ba(2019)。gydF4y2Ba

游勇,陈涛,沈勇,王哲,图表对比学习自动化。在gydF4y2Ba机器学习国际会议gydF4y2Ba, Vol. 139, 12121-12132(2021)。gydF4y2Ba

确认gydF4y2Ba

本研究得到国家自然科学基金项目(62276082、61876052)、PCL重大重点项目(PCL2021A06)、深圳市战略性新兴产业发展专项基金(20200821174109001)、工业和信息化部、国家卫生健康委员会5G +健康应用试点项目(5G +罗湖医院集团:居民健康管理新模式的尝试)的部分资助。gydF4y2Ba

作者信息gydF4y2Ba

作者及隶属关系gydF4y2Ba

贡献gydF4y2Ba

Xu.Z。提出研究,进行实验,分析数据,撰写稿件。改进手稿。B.T.监督整个项目。gydF4y2Ba

相应的作者gydF4y2Ba

道德声明gydF4y2Ba

相互竞争的利益gydF4y2Ba

作者声明没有利益竞争。gydF4y2Ba

同行评审gydF4y2Ba

同行评审信息gydF4y2Ba

化学通讯gydF4y2Ba感谢蒋胜利和另一位匿名审稿人对本工作的同行评议所作的贡献。gydF4y2Ba同行评审报告gydF4y2Ba是可用的。gydF4y2Ba

额外的信息gydF4y2Ba

出版商的注意gydF4y2Ba施普林格自然对出版的地图和机构从属关系中的管辖权主张保持中立。gydF4y2Ba

补充信息gydF4y2Ba

权利和权限gydF4y2Ba

开放获取gydF4y2Ba本文遵循知识共享署名4.0国际许可协议(Creative Commons Attribution 4.0 International License),允许以任何媒介或格式使用、分享、改编、分发和复制,只要您对原作者和来源给予适当的署名,提供知识共享许可协议的链接,并注明是否有更改。本文中的图像或其他第三方材料包含在文章的创作共用许可中,除非在材料的信用额度中另有说明。如果内容未包含在文章的创作共用许可协议中,并且您的预期使用不被法定法规所允许或超出了允许的使用范围,您将需要直接获得版权所有者的许可。要查看此许可证的副本,请访问gydF4y2Bahttp://creativecommons.org/licenses/by/4.0/gydF4y2Ba.gydF4y2Ba

关于本文gydF4y2Ba

引用本文gydF4y2Ba

臧旭,赵晓霞,唐晓霞。基于层次分子图自监督学习的属性预测方法。gydF4y2BaCommun化学gydF4y2Ba6gydF4y2Ba, 34(2023)。https://doi.org/10.1038/s42004-023-00825-5gydF4y2Ba

收到了gydF4y2Ba:gydF4y2Ba

接受gydF4y2Ba:gydF4y2Ba

发表gydF4y2Ba:gydF4y2Ba

DOIgydF4y2Ba:gydF4y2Bahttps://doi.org/10.1038/s42004-023-00825-5gydF4y2Ba

评论gydF4y2Ba

通过提交评论,您同意遵守我们的gydF4y2Ba条款gydF4y2Ba而且gydF4y2Ba社区指导原则gydF4y2Ba.如果您发现一些滥用或不符合我们的条款或指导方针,请标记为不适当。gydF4y2Ba